卷积神经网络(CNN)

相比全连接而言,参数更少,原因在于CNN是一种局部连接,权值共享的模式

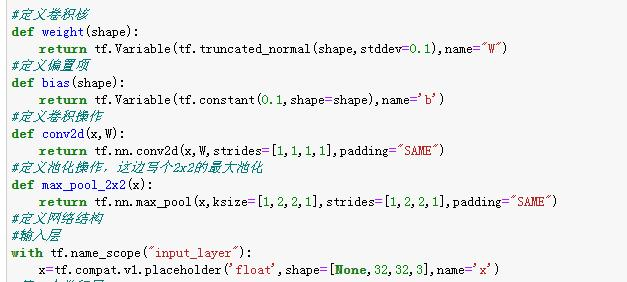

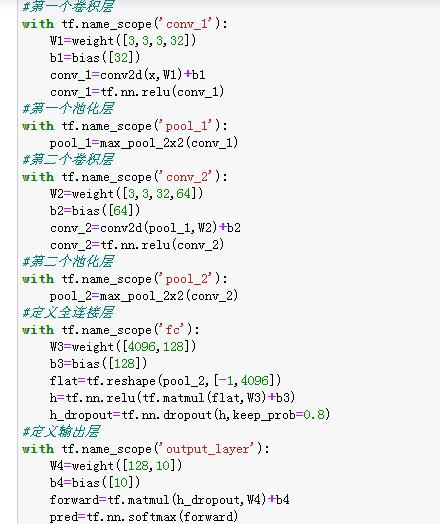

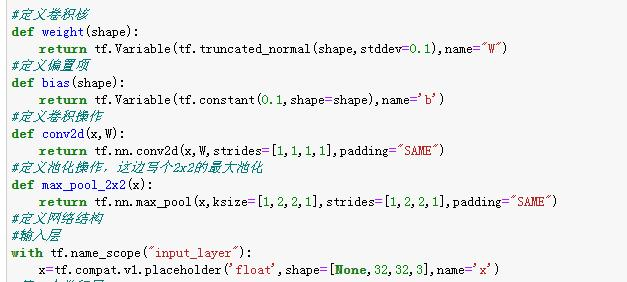

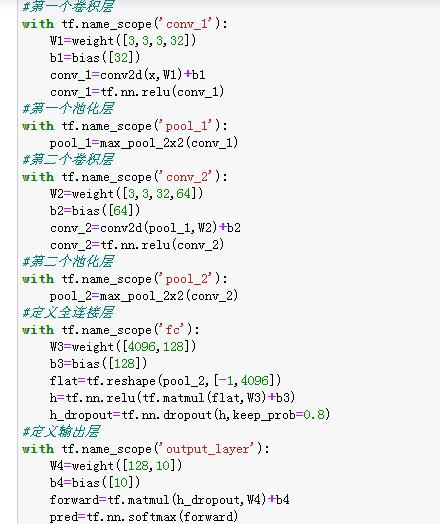

卷积核其实就是一个权值矩阵,例如咱们在全连接网络时,权值是一个列向量,在卷积的时候,我们把这个列向量二维化了

卷积核遍历图像矩阵的过程就称之为卷积

池化实质上是在语义上把相似的特征合并起来,可以达到降维,减少参数的作用

步长是卷积核在图片上每次移动的格数,卷积后特征图的大小就是原图像宽高减分别卷积核的宽高,除以步长加1

即[(原宽-核宽)/步长+1,(原高-核高)/步长+1]

卷积神经网络(CNN)

相比全连接而言,参数更少,原因在于CNN是一种局部连接,权值共享的模式

卷积核其实就是一个权值矩阵,例如咱们在全连接网络时,权值是一个列向量,在卷积的时候,我们把这个列向量二维化了

卷积核遍历图像矩阵的过程就称之为卷积

池化实质上是在语义上把相似的特征合并起来,可以达到降维,减少参数的作用

步长是卷积核在图片上每次移动的格数,卷积后特征图的大小就是原图像宽高减分别卷积核的宽高,除以步长加1

即[(原宽-核宽)/步长+1,(原高-核高)/步长+1]