完整教程:AI 术语通俗词典:Diffusion Models(扩散模型)

扩散模型(Diffusion Models)是近年来生成式人工智能(Generative AI)最重要的突破之一。它广泛应用于图像生成、语音合成、3D 建模等领域,也是 Stable Diffusion、Imagen 等著名文生图模型的核心技术。

理解当代 AIGC(AI Generated Content)技术的关键一步。就是理解扩散模型,

一、术语定义

一种基于概率生成的模型。就是Diffusion Models(扩散模型)

其核心思想是:

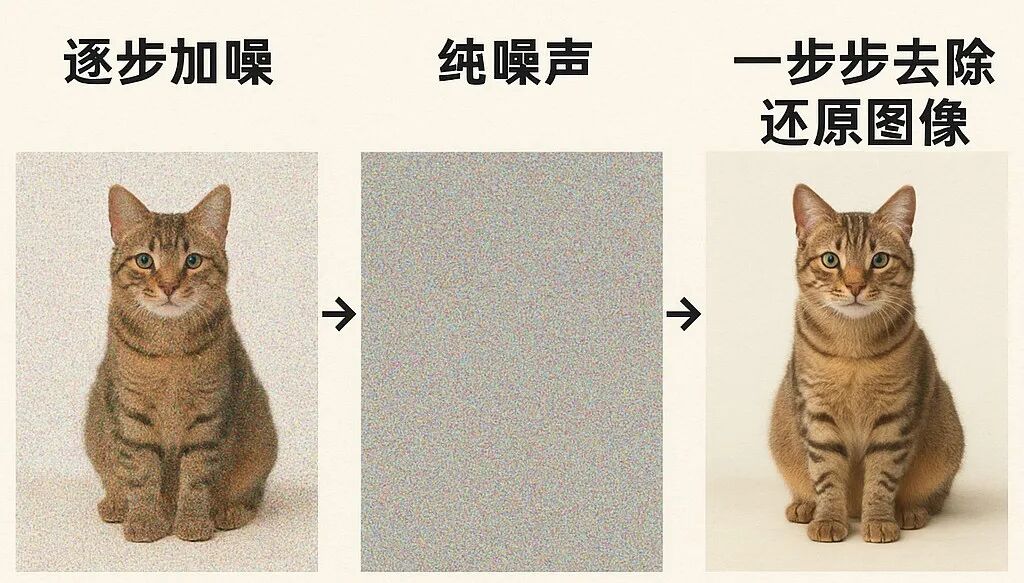

1、正向扩散(Forward Process):逐步向数据中添加噪声,使其趋近纯噪声。

2、反向扩散(Reverse Process):模型学习如何一步步去掉噪声,直到生成一张与训练分布一致、与原图相似的图像。

通过最终,模型能够从随机噪声中逐步生成与真实分布相似的新内容(如图片),而不仅仅是对已有数据的修改。

示意图由 DALL-E 生成

与人类类比:

可以把扩散模型理解成一个“逆向拼图大师”:

普通拼图:从完整拼图逐步拆开,终于剩下一堆碎片。

扩散模型:训练计算机从“碎片堆”(噪声)一步步拼回一幅全新的拼图。

二、提出背景

在扩散模型之前,生成模型主要有两大路线:

1、GAN(生成对抗网络)

优点:效果好、速度快于扩散模型。

缺点:训练不稳定,模式崩塌(mode collapse)严重。

2、VAE(变分自编码器)

优点:数学理论完整,收敛稳定。

缺点:生成图像往往模糊。由于重构目标偏向平均化,导致细节损失。

扩散模型提出后,兼具稳定训练与高保真生成的优势,逐渐成为主流。

三、工作原理

扩散模型的工作流程可以概括为三步:

1、正向扩散(Forward Diffusion)

给一张清晰的图片,逐步加噪:

第 1 步:加一点噪声

第 10 步:轮廓模糊

第 100 步:几乎全是噪声

2、反向扩散(Reverse Diffusion)

模型学习如何一步步去掉噪声,直到生成一张与原始数据分布相似的图像。

3、生成阶段(Generation)

给模型一张“纯噪声”,它会学会如何一步步还原,最终生成一张“全新”的图像。

这种过程,就像一位画家:先面对一张布满杂乱笔迹的画布,然后一层层擦除、修正,最终画出一幅全新作品。

四、典型模型

1、DDPM(Denoising Diffusion Probabilistic Models, 2020)

扩散模型的开创性论文,提出完整的概率建模框架。

2、DDIM(Denoising Diffusion Implicit Models, 2020)

改进采样方法,加快生成速度。

3、Latent Diffusion(潜在扩散模型,2022)

代表作:Stable Diffusion。

不直接在像素空间扩散,而是在“潜在空间”中操作,大幅降低计算量,让个人电脑也能跑生成。

五、应用场景

1、图像生成

文生图(Text-to-Image):Stable Diffusion、DALL·E、MidJourney。

图生图(Image-to-Image):修复老照片、风格迁移、图像上色。

2、语音与音频

扩散模型能生成接近人类自然声音的高质量语音,并被用于音乐合成与音频修复。

3、视频与 3D

Video Diffusion Models:生成短视频。

3D Diffusion Models:建模游戏场景或虚拟现实。

小结

一种基于噪声学习的生成模型。就是本质:扩散模型

优势:训练稳定,生成高保真细节。

代表:DDPM、DDIM、Stable Diffusion。

应用:图像生成、语音合成、视频生成、3D 建模。

扩散模型让 AI 真正具备了“从无到有创造”的能力,是推动 AIGC 浪潮的核心引擎。

鼓励”就是“点赞有美意,赞赏