这种图 数目 分数 标签的图 我想问 它这里标签会重合 那是想反映识别上的问题?

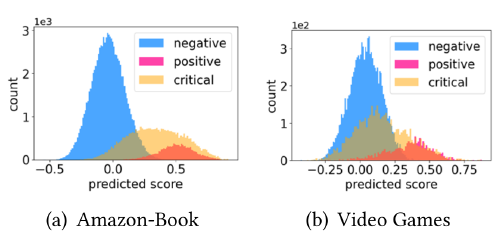

这种图叫做直方图,通常用来展示数据的分布情况。图中不同颜色的区域代表不同的标签(如negative、positive、critical),它们在横轴上的分布显示了每个标签在不同预测分数区间的数量。

标签重合的现象可能反映了几个问题:

-

分类边界不清晰:如果不同标签的分布区域有重叠,可能意味着分类器在这些分数区间内难以区分不同类别。这可能是由于分类器的性能限制,或者是数据本身的特征不够明显。

-

数据不平衡:如果某个标签的分布区域明显比其他标签小,可能表明该标签在数据集中的样本数量较少,这可能导致模型对该标签的识别能力较弱。

-

模型性能问题:如果模型在某些分数区间内对不同标签的区分能力较差,可能会导致标签重合。这可能是模型训练不足、特征选择不当或模型复杂度不够等原因造成的。

-

特征空间的复杂性:在某些情况下,数据的特征空间可能本身就很复杂,导致不同类别之间的边界模糊,这在高维数据中尤为常见。

为了解决这些问题,可以考虑以下方法:

- 改进模型:使用更复杂的模型或调整现有模型的参数,以提高分类的准确性。

- 特征工程:提取或构造更具区分性的特征,帮助模型更好地区分不同类别。

- 数据增强:通过数据增强技术增加某些标签的样本数量,以减少数据不平衡的影响。

- 后处理:在模型预测后进行后处理,如阈值调整,以减少标签重合的情况。

总之,标签重合是模型识别能力的一个反映,通过分析和改进可以提高模型的性能。

我在想他最后重合的地方 是不是容易预测不准确的

是的,你的理解是正确的。图中标签重合的区域通常表示模型在这些预测分数区间内对不同类别的区分能力较弱,因此预测的准确性可能会降低。具体来说:

-

分类边界模糊:在重合区域,不同类别的样本在特征空间中非常接近,导致分类器难以明确区分它们。这种模糊的边界使得模型容易将一个类别的样本错误地分类为另一个类别。

-

预测不确定性:重合区域的样本可能具有较高的预测不确定性,因为模型在这些区域的置信度较低。这意味着模型对这些样本的预测结果可能不够可靠。

-

数据噪声:重合区域可能包含一些噪声数据或异常值,这些数据点的特征与其他样本不同,进一步增加了分类的难度。

-

类别不平衡:如果某个类别在重合区域的样本数量较少,模型可能会对该类别的识别能力较弱,从而导致更多的误分类。

为了提高模型在重合区域的预测准确性,可以采取以下措施:

-

特征选择和工程:提取或构造更具区分性的特征,帮助模型更好地区分不同类别。

-

数据预处理:对数据进行归一化、标准化等预处理,减少不同特征之间的尺度差异。

-

模型优化:使用更复杂的模型或调整现有模型的参数,以提高分类的准确性。

-

数据增强:通过数据增强技术增加某些类别的样本数量,以减少类别不平衡的影响。

-

集成学习:使用集成学习方法(如随机森林、梯度提升树等)来提高模型的泛化能力。

-

后处理:在模型预测后进行后处理,如阈值调整、投票机制等,以减少误分类。

通过这些方法,可以提高模型在重合区域的预测准确性,从而改善整体的分类性能。

分数和概率

在三分类问题中,模型的输出通常是一个分数向量,其中包含三个元素,每个元素对应一个类别的预测分数。这些分数可以是逻辑回归的原始输出,或者是神经网络中softmax层之前的输出。

1. 原始分数( logits )

在神经网络中,这些原始分数通常被称为logits。Logits是没有经过任何转换的原始预测值,它们可以是任何实数。在逻辑回归中,这些分数是通过模型的线性组合得到的。

2. 转换为概率

为了将这些logits转换为概率,我们通常使用softmax函数。Softmax函数可以将一个包含任意实数的向量转换为一个概率分布,其中每个元素的值都在0到1之间,并且所有元素的和为1。

对于三分类问题,softmax函数定义如下:

[ P(y_i|x) = \frac{e{z_i}}{\sum_{j=1} e^{z_j}} ]

其中:

- ( P(y_i|x) ) 是给定输入 ( x ) 属于类别 ( i ) 的概率。

- ( z_i ) 是模型为类别 ( i ) 输出的logit。

- ( e^{z_i} ) 是logit的指数函数,确保所有输出都是正数。

- 分母是所有类别logit指数的总和,确保输出的概率和为1。

3. 选择预测类别

模型的最终预测类别是概率最高的那个类别。即:

[ \text{Predicted Class} = \arg\max_i P(y_i|x) ]

这意味着模型会选择使得 ( P(y_i|x) ) 最大的 ( i ) 作为预测类别。

4. 概率和分数的关系

- 分数(logits):模型直接输出的原始预测值,可以是任何实数。

- 概率:通过softmax函数将logits转换为概率分布,每个类别的概率表示模型对该类别的“信心”程度。

示例

假设一个三分类问题的模型输出了以下logits向量:

[ [2.0, 0.5, -1.0] ]

应用softmax函数:

[ P(y_1|x) = \frac{e{2.0}}{e + e^{0.5} + e^{-1.0}} ]

[ P(y_2|x) = \frac{e{0.5}}{e + e^{0.5} + e^{-1.0}} ]

[ P(y_3|x) = \frac{e{-1.0}}{e + e^{0.5} + e^{-1.0}} ]

计算得到:

[ P(y_1|x) \approx 0.865 ]

[ P(y_2|x) \approx 0.106 ]

[ P(y_3|x) \approx 0.029 ]

模型将预测类别为1,因为其概率最高。

总结来说,在三分类问题中,模型的输出分数(logits)通过softmax函数转换为概率,模型根据概率最高的类别进行预测。这种转换使得模型的输出可以被解释为对每个类别的“信心”程度。