生成式人工智能(Generative AI, GenAI)的浪潮正以前所未有的速度席卷全球,重塑了从内容创作到科学研究的每一个领域。对于像美国能源部(DOE)这样肩负着国家能源安全、核安全、环境管理及尖端科学研究使命的机构而言,GenAI 不仅是一个提高效率的工具,更是推动下一代科研突破的关键赋能技术。

为了在最大化 GenAI 潜力的同时,确保其安全、可靠和负责任的使用,DOE 发布了《生成式人工智能参考指南》(Generative AI Reference Guide)。这份指南并非一份僵硬的政策指令,而是一份面向 DOE 联邦雇员和承包商的综合技术参考文件。它旨在确立一个清晰的框架,指导整个 DOE 生态系统理解、采纳和驾驭这一强大的技术。

本文将深入剖析这份指南的核心精神、技术考量、联邦合规要求,以及 DOE 为负责任地使用 GenAI 所建立的七大风险管理支柱和操作化最佳实践。

1. GenAI 的定位与核心:“人类在环”

DOE 对 GenAI 的采纳,基于一个核心哲学:GenAI 应被视为副驾驶(Copilot) ,而非自主决策者。

1.1 GenAI 的技术定义

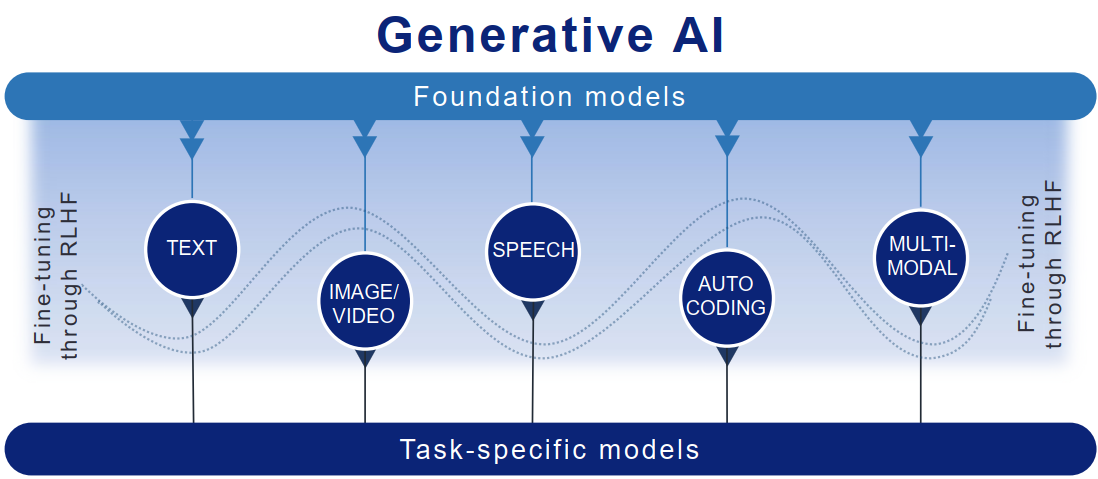

GenAI 属于 AI 模型的一个子集,其核心能力在于生成衍生的合成内容。这与传统的判别式 AI(如分类模型)有本质区别。GenAI 通过学习海量输入数据的内在结构、模式和特征,从而创造出全新的、但与输入数据具有统计相似性的内容,涵盖文本、代码、图像、音频等。

基础模型(Foundation Models) 是 GenAI 的基石。这些模型(如 LLMs)在大规模、多样化的未标记数据上进行预训练,展现出涌现能力(Emergent Abilities),即在训练过程中没有明确编程但自动获得的能力。DOE 指南强调,正是这种特性使得模型在处理各种下游任务时具备惊人的泛化性,但也引入了难以预测的行为风险。

1.2 责任链条与人工干预机制

在 DOE 体系内使用 GenAI,“人类责任”是不可动摇的原则。指南明确指出:

- 对产出负全责:使用者,而非 GenAI 工具本身,必须对使用 GenAI 技术所产生的任何结果、行动或决策负最终责任。

- 人类在环(Human in the Loop, HITL) :这不仅仅是一个建议,而是一个强制性的风险缓解策略。任何 GenAI 的产出,无论是科学报告的初稿、一段代码,还是对数据的摘要,都必须经过人类专家的审查、验证和最终批准。

- 决策辅助:GenAI 系统应被用于辅助和通知决策过程,而非替代决策过程。特别是在涉及到国家安全、重大资金分配或环境影响的关键领域。

这一哲学设定了技术使用的边界:GenAI 是提高效率和初创能力的工具,但最终的准确性、伦理性和合规性,必须由人类来保障。

2. GenAI 的价值矩阵:四大核心功能与应用潜力

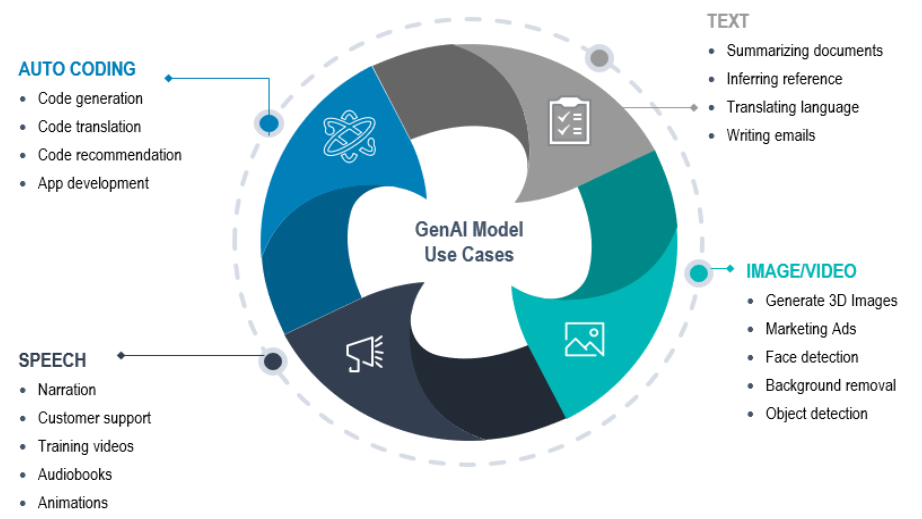

DOE 指南将 GenAI 的文本-文本功能(目前最常用和最有影响力的应用)归纳为四大核心功能。这些功能是 DOE 系统利用 GenAI 来提高科学生产力和行政效率的蓝图。

2.1 总结:知识提炼的加速器

技术挑战与价值:在 DOE 及其国家实验室中,科研人员每天面对大量的技术报告、专利、法规文件和实验数据。GenAI 的总结能力可以快速识别关键信息、提炼核心论点,极大地缩短信息获取和处理时间。

风险考量:

- 信息丢失:过度压缩可能丢失关键的上下文信息。

- 关键事实遗漏:模型可能“认为”某些信息不重要而将其遗漏。

最佳实践:使用者应利用提示工程指定总结的长度、目标受众和必须包含的关键主题,并人工对照原文检查是否有关键事实被错误遗漏或误读。

2.2 推理:模式发现与洞察生成

技术挑战与价值:推理功能涉及基于输入文本进行预测、情感分析、或从大量数据中提取特定模式。例如,分析项目提案的情感倾向,或从历史事故报告中识别潜在的安全漏洞模式。

风险考量(高风险区) :

- 虚假相关性:模型可能基于统计相关性而非因果关系进行推理,产生误导性洞察。

- 隐私泄露:若推理涉及包含个人身份信息的数据,模型的处理过程可能无意中暴露隐私。

最佳实践:推理结果必须被视为假设,并需要通过传统的统计学或实验方法进行二次验证。涉及敏感或受控数据的推理任务,应仅在批准的、受控的、可本地部署的 GenAI 环境中进行。

2.3 转换:跨语言与跨格式的桥梁

技术挑战与价值:转换功能包括语言翻译、风格或语气调整(如将科学论文转换为政策简报),以及代码生成(将自然语言指令转换为 Python、Julia 或 Fortran 等科学计算语言)。代码转换是 DOE 国家实验室提高计算效率的关键潜力点。

风险考量:

- 语义失真:技术术语或科学公式在翻译或风格转换中可能出现语义损失或误解。

- 代码安全漏洞:GenAI 生成的代码可能包含安全漏洞(如注入攻击风险) ,或效率低下的“冗余代码”。

最佳实践:

- 代码审计:任何 GenAI 生成的代码必须经过严格的同行评审和安全审计,尤其是在部署到高性能计算系统或生产环境之前。

- 后处理检查:对所有转换后的技术内容,必须由领域专家进行技术准确性检查。

2.4 扩展:内容创作的加速与幻觉风险

技术挑战与价值:扩展功能是 GenAI 最直观的能力,用于在给定输入(提示)的基础上创建全新的、连贯的内容。例如,起草政策草案、生成新闻稿、或撰写实验报告的背景部分。

风险考量(最高风险区) :

- AI 幻觉(Hallucinations) :模型生成看似流畅和权威,但事实完全错误或捏造的内容。在科学和政策领域,一个幻觉的事实可能导致灾难性后果。

- 知识产权与版权侵权:扩展的内容可能与模型训练数据中的受版权保护的文本高度相似,引发侵权风险。

最佳实践: “零信任”原则适用于所有扩展产出。所有事实、引文、数据点,必须由人工进行逐一的事实核查和溯源。在知识产权方面,DOE 员工应避免依赖 GenAI 来生成核心、独创性的内容,而是将其作为起草辅助工具。

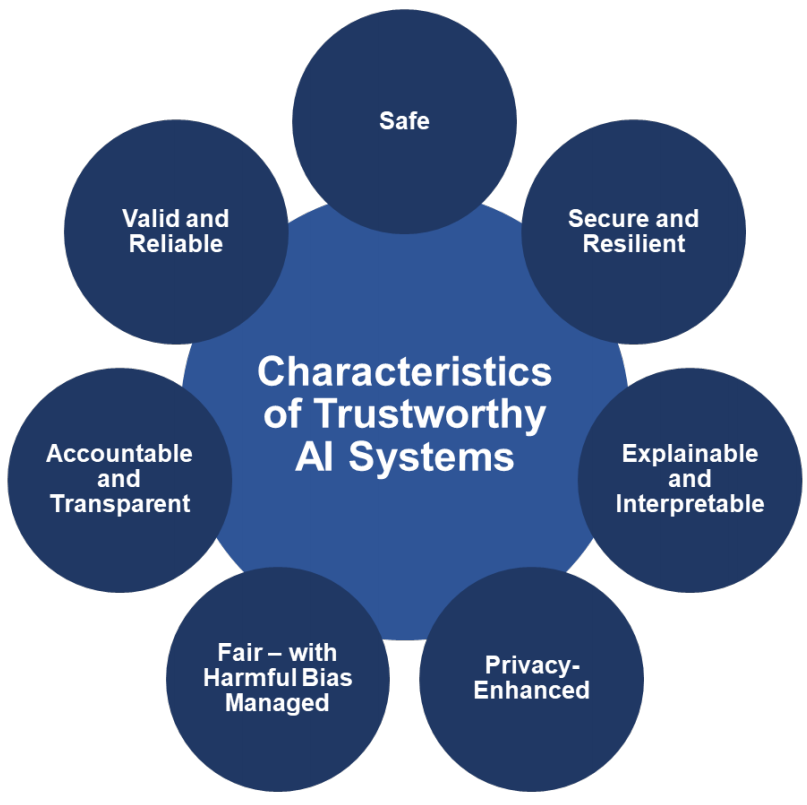

3. 七大可信赖 AI 支柱:DOE 的风险管理框架

3.1 机密性与数据隔离

核心威胁:数据泄露。商业 GenAI 模型(如公共 API)通常会使用用户输入来微调和改进模型。这意味着,任何提交给这些模型的非公开信息(包括:机密、受控非机密、私人或敏感信息)都可能被纳入模型的训练数据,并可能在未来用户的产出中意外暴露。

技术缓解策略:

- 绝对禁令:严禁将任何非公开、敏感、受控或分类信息提交给任何非 DOE 授权的 GenAI 工具。

- 数据脱敏:如果必须使用敏感数据进行内部测试,必须进行严格的脱敏或使用合成数据替代。

- 沙盒环境:在内部建立隔离或严格受控的 GenAI 环境,确保数据不出边界。

3.2 知识产权与创造性界限

核心威胁:专利和版权侵权。美国版权局和专利商标局的现有裁定倾向于:纯粹由 AI 生成的作品或发明不具备人类作者资格,故不可获得版权或专利。

技术缓解策略:

- 人类贡献追踪:在使用 GenAI 辅助发明或撰写技术文件时,必须精确记录人类思维和贡献的具体环节。发明人或作者必须能够清晰地划分“人类独创”部分和“AI 辅助”部分。

- IP 法律咨询:对于任何涉及专利申请或技术成果发表的 GenAI 辅助工作,必须咨询DOE 总法律顾问办公室或实验室专利律师。

- 版权声明:在公开发布的材料中,应考虑明确披露 GenAI 的使用程度,以保持透明度。

3.3 安全性与系统故障弹性

核心威胁:AI 系统意外或恶意行为导致的物理或网络安全威胁。在操作关键基础设施(如核设施、电网)或进行危险实验的 DOE 环境中,GenAI 的错误输出可能导致物理灾难。

技术缓解策略:

- 安全设计:在 AI 系统的设计阶段就融入安全需求。

- 冗余验证:GenAI 的输出绝不能直接输入到关键操作或物理控制系统。必须通过独立、传统、经认证的控制系统进行二次验证。

- 异常检测:建立强大的异常检测和监控机制,以便立即识别并隔离 AI 系统的异常行为或“出界”的产出。

3.4 公平性和偏差

核心威胁:训练数据中的内在偏差被模型放大,导致对特定群体(例如在人才招聘、项目资助或社区影响评估中)产生不公平的歧视性结果。

技术缓解策略:

- 数据审计:在模型部署前,对训练数据集进行严格的偏差审计,特别是关于敏感属性(如种族、性别、地域)的表示。

- 指标定义:在 AI 系统开发初期,明确定义“公平性”指标(如平等机会、统计奇偶性),并进行系统性测试。

- 社会影响评估:对可能影响公众的 AI 应用,进行社会和伦理影响评估,确保其产出不会对弱势或少数群体造成不成比例的负面影响。

3.5 AI 幻觉和误解

核心威胁:捏造事实。由于 GenAI 模型本质上是概率性文本生成器,它并不“理解”真相,只会生成听起来最合理的词串。在科研和政策制定中,一个幻觉的事实可能比“不知道”更具破坏性。

技术缓解策略:

- 事实核查文化:将人工事实核查作为 GenAI 使用流程中不可跳过的步骤。

- 检索增强生成:优先使用检索增强生成(RAG)架构。 该技术允许模型从权威、受控的 DOE 知识库中检索信息,然后基于检索到的事实进行生成,从而锚定模型的输出并大幅减少幻觉。

- 提示工程:使用高精确度提示,如“只使用我提供的[文件名/数据源]来回答。如果信息不在该文件中,则回答‘信息不足’。”

3.6 安全性和弹性

核心威胁:恶意提示攻击、数据中毒和模型窃取。攻击者可能通过精心构造的输入绕过模型的安全护栏,或通过污染训练数据来操纵模型的行为。

技术缓解策略:

- 红队演习:定期对 GenAI 系统进行对抗性测试,模拟恶意提示攻击、数据注入等,以发现和修补漏洞。

- 输入/输出过滤:部署强大的内容过滤机制,在模型接收输入前和生成输出后,分别检查是否有恶意代码、敏感信息或不合规内容。

- 持续监控:对模型性能、准确性和安全日志进行实时监控,以便在模型被操纵时快速响应。

3.7 隐私与个人信息保护

核心威胁:训练数据中的个人信息泄露,以及模型在推理过程中无意中重构或推断出敏感的个人身份信息。

技术缓解策略:

- 隐私影响评估:所有涉及个人数据处理的 GenAI 应用,必须在部署前完成隐私影响评估,确保符合《隐私法案》和 OMB 的要求。

- 差分隐私:在涉及大规模个人数据分析时,考虑采用差分隐私技术,在训练或查询阶段加入数学噪声,以保证个体数据无法被识别。

- PII/PHI 屏蔽:部署自动化的数据屏蔽或匿名化工具,在数据进入 GenAI 环境之前,对所有 PII 和 PHI 进行严格过滤和清理。

4. 行动项与治理框架

为了将上述原则落地,DOE 指南提出了具体的行动项和治理要求。

4.1 合规性基石:联邦 AI 政策

DOE GenAI 的使用必须以联邦法规为基石。指南强调的联邦框架包括:

- 行政命令 14110:要求联邦机构推进 AI 的安全、可靠和可信赖使用。关键在于 EO 14110不鼓励对 GenAI 施加广泛禁令,这促使 DOE 寻求负责任的采纳路径。

- OMB 备忘录(M-24-10) :设定了 AI 治理、创新和风险管理的具体要求,特别是要求机构在关键/高风险应用中进行影响评估。

- DOE 内部数据管理政策:所有数据分类、处理和存储的现有规定,在 GenAI 环境下依然适用。

4.2 技术与流程的最佳实践

-

Prompt 工程的纪律:用户应将 Prompt 视为一种形式化输入。鼓励采用零样本(Zero-Shot)、少样本(Few-Shot)或 CoT(Chain-of-Thought)等高级提示技术来提高产出的可靠性,并在提示中明确约束模型的行为(例如:“你的角色是[领域专家],请使用[特定格式]回答”)。

-

可重现性与溯源:AI 模型的科学应用必须保证结果的可重现性。这意味着必须对:

- 训练输入数据

- 模型架构和参数

- 提示工程的具体文本和版本

- 模型的版本和日期

- 进行全面的版本控制和记录,以供审计和验证。

-

持续学习与能力建设:鉴于 GenAI 技术的快速迭代,DOE 要求员工进行持续的AI 素养和伦理培训,确保他们理解模型的能力界限、最新的攻击向量和相应的缓解措施。

总结 :在变革中保持稳定与卓越

美国能源部《生成式人工智能参考指南》是一份极具前瞻性的文件。它没有选择简单的一刀切禁令,而是选择了一条更具挑战性但也更有回报的路径:在严格的风险治理框架下,积极探索和利用 GenAI 推动国家科学和安全使命。

这份指南的核心信息是清晰且不可妥协的:GenAI 是工具,人类是主人;GenAI 是副驾驶,人类是飞行员。 负责任地使用 GenAI,意味着对每一个输出保持批判性思维,对每一个输入保持谨慎,并始终将国家安全、数据机密性和伦理公平置于技术便利之上。