掩码注意力(Causal Attention)是生成式模型的核心技术,它传统自注意力机制有根本的不同,掩码注意力限制模型只能关注当前位置之前的tokens,确保了自回归生成的因果性。

自注意力的掩码

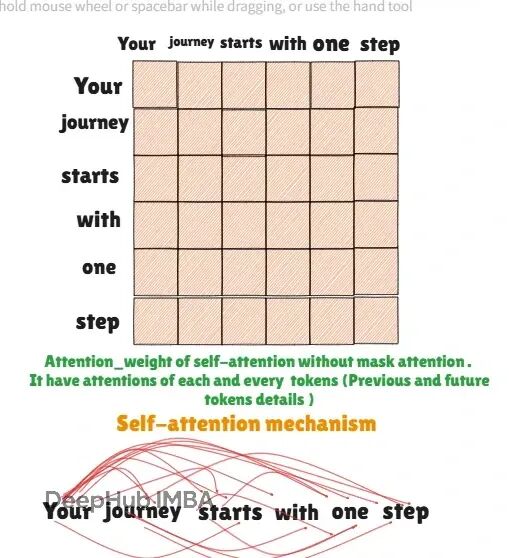

自注意力机制在Transformer编码器和BERT等模型中广泛应用。这种机制的特点是每个token都能访问序列中的所有其他tokens,包括前面和后面的位置。这种双向注意力让模型能够充分利用上下文信息,将静态词嵌入转换为富含语境的动态表示。

而掩码注意力作为解码器的关键组件,人为地阻断了对未来tokens的访问。这种单向约束虽然看起来是限制,实际上正是语言生成任务的核心要求——模型必须基于已有的上下文来预测下一个词,而不能"偷看"答案。

https://avoid.overfit.cn/post/1eaccf4c67f74b27839e3c5b2372f23c