概述

Ceph 是一个开源的软件定义存储平台,它在单个分布式计算机集群上实现对象存储,并提供对象级、块级和文件级存储的三合一接口。Ceph 存储集群由 Ceph 监视器、Ceph 管理器、Ceph 元数据服务器和 OSD 组成,它们协同工作来存储和复制数据,供应用程序、Ceph 用户和 Ceph 客户端使用。Ceph 还提供了使用 PostgreSQL 来利用网络存储的选项。

在这篇文章中,我将指导你通过一个简单的过程在单台机器上搭建一个一体化的 Ceph 存储集群,这样你就可以使用这个设置来运行简单的与存储相关的实验性开发或测试。

搭建 Ceph 存储集群

一个可用于生产环境的 Ceph 存储集群应该包含所有必要的组件以正确管理存储,但这篇博客文章旨在提供一个简单的设置,让开发人员能够快速体验网络存储集群。

搭建基础环境

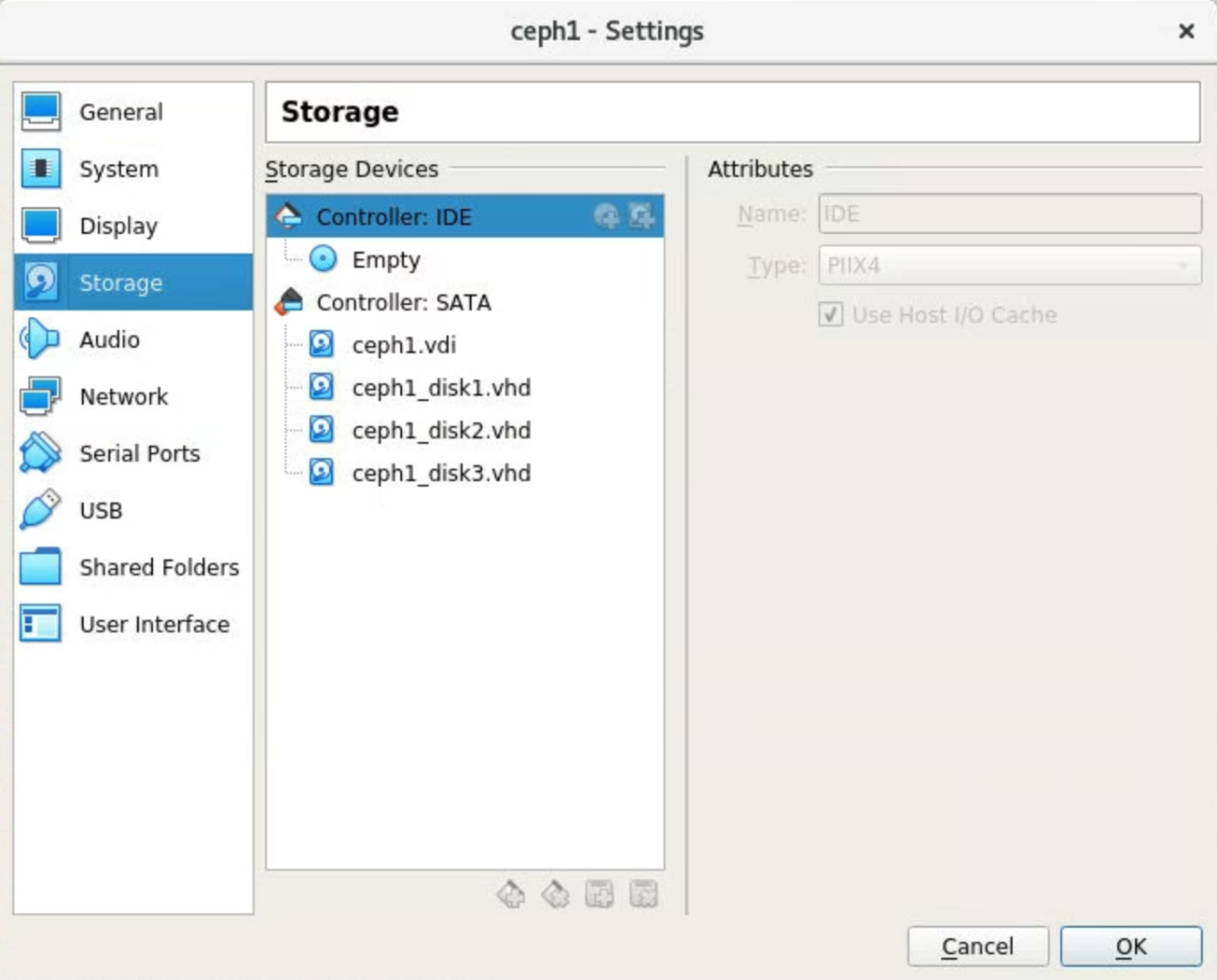

在本节中,我使用了一台在 VirtualBox 上运行的 CentOS 7 虚拟机,并添加了三个虚拟硬盘(VHD)。这台虚拟机的存储设置如下图所示:

登录到 CentOS 后,通过运行以下命令添加一个名为 ceph 的新用户:

$ sudo useradd -d /home/ceph -m ceph

$ sudo passwd ceph

$ echo "ceph ALL = (root) NOPASSWD:ALL" | sudo tee /etc/sudoers.d/ceph

$ sudo chmod 0440 /etc/sudoers.d/ceph

$ su - ceph

然后使用以下命令安装基本软件包。Docker 用作容器,NTP 用于同步时钟:

$ sudo yum update

$ sudo yum install lvm2 docker ntp ntpdate ntp-doc python3

检查状态,确保 Docker 和 NTPD 都正常运行:

$ sudo systemctl status ntpd

$ sudo systemctl status docker

搭建集群监视器

有许多工具可用于管理 Ceph 存储集群,但我们将使用简单的 cephadm 作为我们的管理工具。

首先,切换到主目录并通过以下命令下载 cephadm:

$ cd ~

$ curl --silent --remote-name --location https://github.com/ceph/ceph/raw/octopus/src/cephadm/cephadm

$ chmod +x cephadm

接下来,添加 Octopus 版本的仓库并安装 cephadm:

$ sudo ./cephadm add-repo --release octopus

$ sudo ./cephadm install

现在,使用 cephadm 引导程序在 Ceph 存储集群中设置第一个监视器守护进程。将 192.168.0.134 替换为你实际的服务器 IP 地址。我们将使用简单的用户名和密码 admin/password 来简化设置,否则 cephadm 会生成一个随机密码,并要求你在首次登录时更改它。

$ sudo ./cephadm bootstrap --mon-ip 192.168.0.134 --dashboard-password-noupdate --initial-dashboard-user admin --initial-dashboard-password password

如果一切顺利运行,你应该会看到类似以下的一些消息。

Ceph Dashboard is now available at:URL: https://localhost.localdomain:8443/User: adminPassword: passwordYou can access the Ceph CLI with:sudo ./cephadm shell --fsid 1117491a-ca74-11ed-87fc-080027a1115e -c /etc/ceph/ceph.conf -k /etc/ceph/ceph.client.admin.keyringPlease consider enabling telemetry to help improve Ceph:ceph telemetry onFor more information see:https://docs.ceph.com/docs/master/mgr/telemetry/

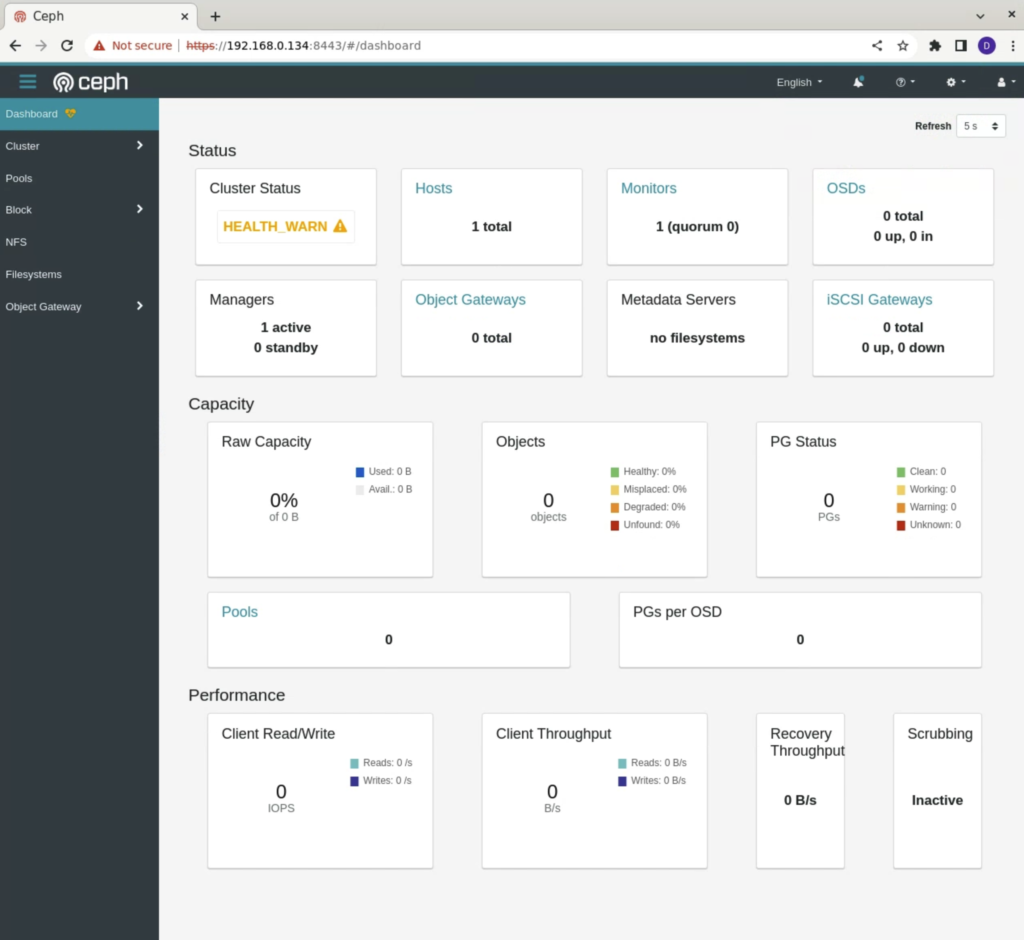

设置好集群监视器后,使用 Web 浏览器登录并检查当前状态。通常会显示如下所示的仪表板:

你也可以安装一些常用工具,通过命令行检查 Ceph 存储集群:

$ sudo cephadm install ceph-common

然后,使用以下命令检查状态,你应该会看到类似以下的输出:

$ sudo ceph statuscluster:id: 1117491a-ca74-11ed-87fc-080027a1115ehealth: HEALTH_WARNOSD count 0 < osd_pool_default_size 3services:mon: 1 daemons, quorum localhost.localdomain (age 9m)mgr: localhost.localdomain.trwhwk(active, since 8m)osd: 0 osds: 0 up, 0 indata:pools: 0 pools, 0 pgsobjects: 0 objects, 0 Busage: 0 B used, 0 B / 0 B availpgs:

搭建对象存储设备

如你在 ceph status 中所见,我们的这个集群中只有一个监视器在运行,但有 0 个 osd(对象存储设备)。在向这个存储集群添加对象存储设备之前,让我们使用 lsblk 检查当前的磁盘状态。

$ lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 80G 0 disk

├─sda1 8:1 0 1G 0 part /boot

└─sda2 8:2 0 79G 0 part├─centos-root 253:0 0 49.8G 0 lvm /├─centos-swap 253:1 0 5G 0 lvm [SWAP]└─centos-home 253:2 0 24.3G 0 lvm /home

sdb 8:16 0 30G 0 disk

sdc 8:32 0 30G 0 disk

sdd 8:48 0 30G 0 disk

sr0 11:0 1 1024M 0 rom

上面是 lsblk 命令的输出,它显示了系统当前的磁盘状态。它列出了所有可用的块设备,包括它们的名称、主要和次要设备编号、大小、类型以及挂载点(如果有的话)。在这种情况下,我们可以看到有三个额外的磁盘(sdb、sdc 和 sdd)尚未被使用。

接下来,让我们使用 Ceph 设备管理命令检查这三个磁盘是否可以添加。

$ sudo ceph orch device ls

Hostname Path Type Serial Size Health Ident Fault Available

localhost.localdomain /dev/sdb hdd VBc50561fa-4658471a 32.2G Unknown N/A N/A Yes

localhost.localdomain /dev/sdc hdd VBc775712c-0dbb8b17 32.2G Unknown N/A N/A Yes

localhost.localdomain /dev/sdd hdd VB4dfb0df0-a8f28653 32.2G Unknown N/A N/A Yes

这三个磁盘在“Available”列中都显示为“是”,表明我们可以将它们添加到存储集群中。要将这些设备添加到集群中,我们需要运行以下命令:

$ sudo ceph orch apply osd --all-available-devices

Scheduled osd.all-available-devices update...

输出表明设备正在处理中,这可能需要一些时间。请等待几秒钟或几分钟,然后检查 ceph 集群状态。

$ sudo ceph statuscluster:id: 1117491a-ca74-11ed-87fc-080027a1115ehealth: HEALTH_OKservices:mon: 1 daemons, quorum localhost.localdomain (age 12m)mgr: localhost.localdomain.trwhwk(active, since 11m)osd: 3 osds: 3 up (since 20s), 3 in (since 20s); 1 remapped pgsdata:pools: 1 pools, 1 pgsobjects: 0 objects, 0 Busage: 3.0 GiB used, 87 GiB / 90 GiB availpgs: 1 active+undersized+remappedprogress:Rebalancing after osd.1 marked in (18s)[............................]

现在我们可以看到,3 个 OSD 已添加到这个 Ceph 存储集群中。如果我们再次运行“lsblk”命令,应该会看到类似以下的输出,表明 sdb、sdc 和 sdd 现在正被 Ceph 存储集群使用。

$ lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 80G 0 disk

├─sda1 8:1 0 1G 0 part /boot

└─sda2 8:2 0 79G 0 part├─centos-root 253:0 0 49.8G 0 lvm /├─centos-swap 253:1 0 5G 0 lvm [SWAP]└─centos-home 253:2 0 24.3G 0 lvm /home

sdb 8:16 0 30G 0 disk

└─ceph--7062ccde--bf6b--4252--ba0a--a66e02c0839d-osd--block--5ca780b0--b4a3--49c3--b58d--3aba26b88d14 253:3 0 30G 0 lvm

sdc 8:32 0 30G 0 disk

└─ceph--c38c357f--71ef--4641--acd4--8cb7bdf53520-osd--block--ae0bc25d--299e--45f0--af4f--890263970f1d 253:4 0 30G 0 lvm

sdd 8:48 0 30G 0 disk

└─ceph--debbc90a--860a--4e8f--9e93--a3c6e48e7994-osd--block--ccd3d288--f87f--4fa3--983a--102d838ea2a1 253:5 0 30G 0 lvm

sr0

如果你的 Ceph 存储集群的健康状态仍然处于 HEALTH_WARN 状态,你可以尝试运行本文中描述的命令来解决该问题。

解决问题后,你的 ceph 存储集群应该处于 HEALTH_OK 状态。

$ sudo ceph statuscluster:id: 1117491a-ca74-11ed-87fc-080027a1115ehealth: HEALTH_OKservices:mon: 1 daemons, quorum localhost.localdomain (age 17m)mgr: localhost.localdomain.trwhwk(active, since 16m)osd: 3 osds: 3 up (since 5m), 3 in (since 5m)data:pools: 1 pools, 1 pgsobjects: 0 objects, 0 Busage: 3.0 GiB used, 87 GiB / 90 GiB availpgs: 1 active+clean

本地测试 Ceph 存储集群

搭建 Ceph 存储集群主要是为了网络存储场景,但我们稍后会考虑块、对象和文件系统的不同访问网络场景。在这里,我们将创建一个 Cephfs 文件系统,将其本地挂载,并执行一个简单的测试。

要创建 Cephfs 文件系统,请运行以下命令并进行验证:

$ sudo ceph fs volume create cephfs

$ sudo ceph fs volume ls

[{"name": "cephfs"}

]

要在本地挂载 cephfs 文件系统,

- 通过运行以下命令为 cephfs 创建一个密钥:

$ sudo ceph fs authorize cephfs client.user / rw | sudo tee /etc/ceph/ceph.client.user.keyring

[client.user]key = AQCcFR5kLAgrERAAdfgLAUqdGvRxghJrLUkBMw==

此命令将创建一个密钥并将其写入密钥环文件。

- 通过运行以下命令挂载 cephfs 文件系统:

$ sudo mount -t ceph :/ /media/cephfs -o name=user,secret=AQCcFR5kLAgrERAAdfgLAUqdGvRxghJrLUkBMw==

此命令将把 cephfs 文件系统挂载到 /media/cephfs 目录。

- 通过运行以下命令将挂载目录的所有权更改为 ceph:ceph:

$ sudo chown -R ceph:ceph /media/cephfs/

- 在挂载目录中创建一个文件并验证其内容:

$ echo "hello ceph storage cluster" > /media/cephfs/hello.txt

$ cat /media/cephfs/hello.txt

hello ceph storage cluster

此时,你可以尝试使用类似以下的一些命令在另一台 CentOS 机器上挂载这个 Ceph 存储集群。不过,我们将在下一篇博客文章中讨论这个主题。

ssh ceph@192.168.0.134 'sudo ceph-authtool -p /etc/ceph/ceph.client.admin.keyring' > client.admin.key

sudo mount -t ceph 192.168.0.134:/ /mnt/cephfs -o name=admin,secretfile=client.admin.key

总结

在这篇博客文章中,我们介绍了在单个虚拟机上搭建简单的 Ceph 存储集群并在 Cephfs 存储集群上执行基本测试的过程。我们创建了一个 Ceph 用户,设置了 Ceph 监视器和管理器,添加了对象存储设备,并创建了一个 Cephfs 文件系统。然后我们在本地挂载了 Cephfs 文件系统,创建了一个文件,并读取其内容以验证挂载是否成功。在未来的文章中,我们将探索更高级的用例,例如使用 Cephfs 文件系统在一体化 Ceph 存储集群上运行 PostgreSQL。