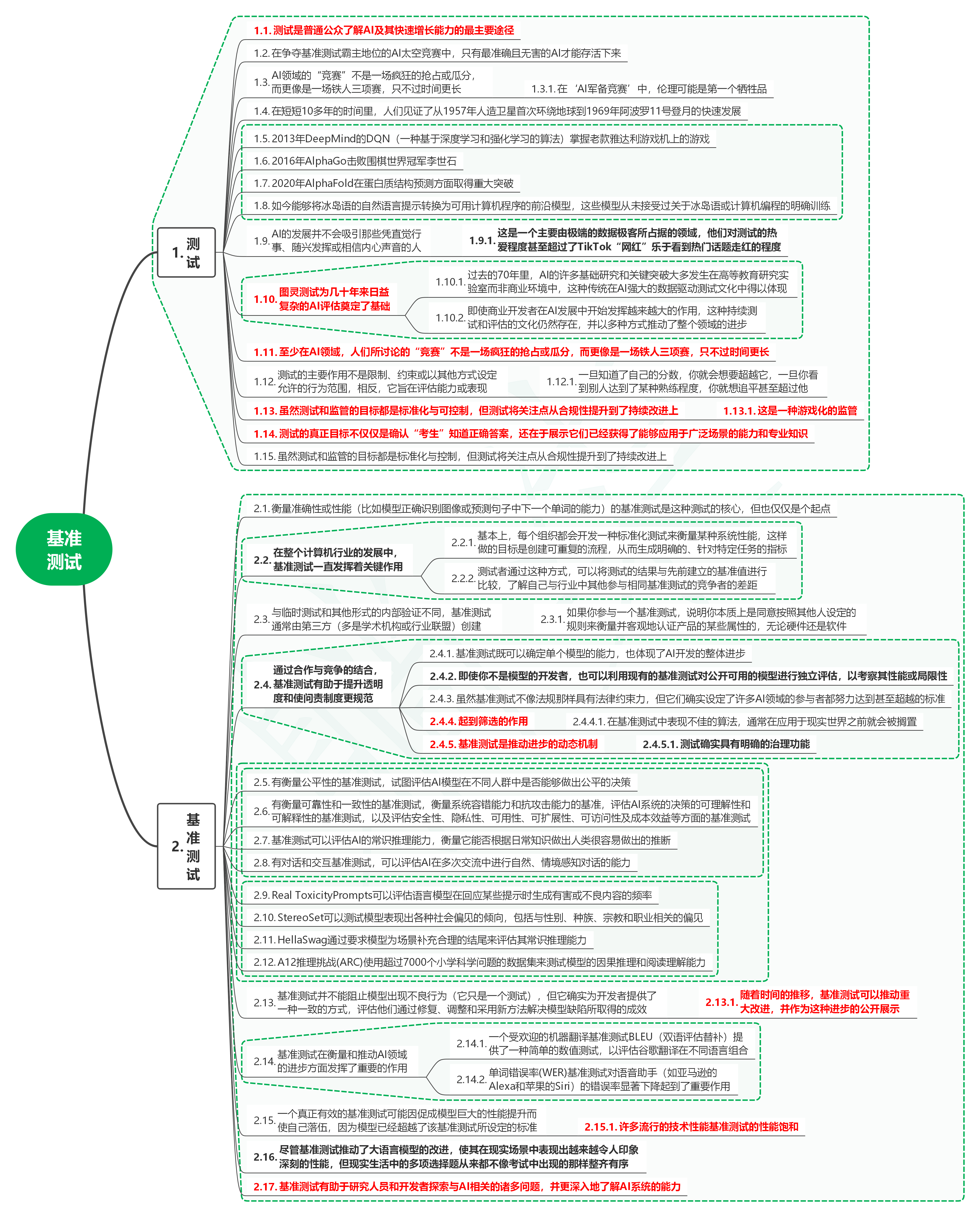

1. 测试

1.1. 测试是普通公众了解AI及其快速增长能力的最主要途径

1.2. 在争夺基准测试霸主地位的AI太空竞赛中,只有最准确且无害的AI才能存活下来

1.3. AI领域的“竞赛”不是一场疯狂的抢占或瓜分,而更像是一场铁人三项赛,只不过时间更长

- 1.3.1. 在‘AI军备竞赛’中,伦理可能是第一个牺牲品

1.4. 在短短10多年的时间里,人们见证了从1957年人造卫星首次环绕地球到1969年阿波罗11号登月的快速发展

1.5. 2013年DeepMind的DQN(一种基于深度学习和强化学习的算法)掌握老款雅达利游戏机上的游戏

1.6. 2016年AlphaGo击败围棋世界冠军李世石

1.7. 2020年AlphaFold在蛋白质结构预测方面取得重大突破

1.8. 如今能够将冰岛语的自然语言提示转换为可用计算机程序的前沿模型,这些模型从未接受过关于冰岛语或计算机编程的明确训练

1.9. AI的发展并不会吸引那些凭直觉行事、随兴发挥或相信内心声音的人

- 1.9.1. 这是一个主要由极端的数据极客所占据的领域,他们对测试的热爱程度甚至超过了TikTok“网红”乐于看到热门话题走红的程度

1.10. 图灵测试为几十年来日益复杂的AI评估奠定了基础

-

1.10.1. 过去的70年里,AI的许多基础研究和关键突破大多发生在高等教育研究实验室而非商业环境中,这种传统在AI强大的数据驱动测试文化中得以体现

-

1.10.2. 即使商业开发者在AI发展中开始发挥越来越大的作用,这种持续测试和评估的文化仍然存在,并以多种方式推动了整个领域的进步

1.11. 至少在AI领域,人们所讨论的“竞赛”不是一场疯狂的抢占或瓜分,而更像是一场铁人三项赛,只不过时间更长

1.12. 测试的主要作用不是限制、约束或以其他方式设定允许的行为范围,相反,它旨在评估能力或表现

- 1.12.1. 一旦知道了自己的分数,你就会想要超越它,一旦你看到别人达到了某种熟练程度,你就想追平甚至超过他

1.13. 虽然测试和监管的目标都是标准化与可控制,但测试将关注点从合规性提升到了持续改进上

- 1.13.1. 这是一种游戏化的监管

1.14. 测试的真正目标不仅仅是确认“考生”知道正确答案,还在于展示它们已经获得了能够应用于广泛场景的能力和专业知识

1.15. 虽然测试和监管的目标都是标准化与控制,但测试将关注点从合规性提升到了持续改进上

2. 基准测试

2.1. 衡量准确性或性能(比如模型正确识别图像或预测句子中下一个单词的能力)的基准测试是这种测试的核心,但也仅仅是个起点

2.2. 在整个计算机行业的发展中,基准测试一直发挥着关键作用

-

2.2.1. 基本上,每个组织都会开发一种标准化测试来衡量某种系统性能,这样做的目标是创建可重复的流程,从而生成明确的、针对特定任务的指标

-

2.2.2. 测试者通过这种方式,可以将测试的结果与先前建立的基准值进行比较,了解自己与行业中其他参与相同基准测试的竞争者的差距

2.3. 与临时测试和其他形式的内部验证不同,基准测试通常由第三方(多是学术机构或行业联盟)创建

- 2.3.1. 如果你参与一个基准测试,说明你本质上是同意按照其他人设定的规则来衡量并客观地认证产品的某些属性的,无论硬件还是软件

2.4. 通过合作与竞争的结合,基准测试有助于提升透明度和使问责制度更规范

-

2.4.1. 基准测试既可以确定单个模型的能力,也体现了AI开发的整体进步

-

2.4.2. 即使你不是模型的开发者,也可以利用现有的基准测试对公开可用的模型进行独立评估,以考察其性能或局限性

-

2.4.3. 虽然基准测试不像法规那样具有法律约束力,但它们确实设定了许多AI领域的参与者都努力达到甚至超越的标准

-

2.4.4. 起到筛选的作用

-

2.4.4.1. 在基准测试中表现不佳的算法,通常在应用于现实世界之前就会被搁置

-

2.4.5. 基准测试是推动进步的动态机制

-

2.4.5.1. 测试确实具有明确的治理功能

2.5. 有衡量公平性的基准测试,试图评估AI模型在不同人群中是否能够做出公平的决策

2.6. 有衡量可靠性和一致性的基准测试,衡量系统容错能力和抗攻击能力的基准,评估AI系统的决策的可理解性和可解释性的基准测试,以及评估安全性、隐私性、可用性、可扩展性、可访问性及成本效益等方面的基准测试

2.7. 基准测试可以评估AI的常识推理能力,衡量它能否根据日常知识做出人类很容易做出的推断

2.8. 有对话和交互基准测试,可以评估AI在多次交流中进行自然、情境感知对话的能力

2.9. Real ToxicityPrompts可以评估语言模型在回应某些提示时生成有害或不良内容的频率

2.10. StereoSet可以测试模型表现出各种社会偏见的倾向,包括与性别、种族、宗教和职业相关的偏见

2.11. HellaSwag通过要求模型为场景补充合理的结尾来评估其常识推理能力

2.12. A12推理挑战(ARC)使用超过7000个小学科学问题的数据集来测试模型的因果推理和阅读理解能力

2.13. 基准测试并不能阻止模型出现不良行为(它只是一个测试),但它确实为开发者提供了一种一致的方式,评估他们通过修复、调整和采用新方法解决模型缺陷所取得的成效

- 2.13.1. 随着时间的推移,基准测试可以推动重大改进,并作为这种进步的公开展示

2.14. 基准测试在衡量和推动AI领域的进步方面发挥了重要的作用

-

2.14.1. 一个受欢迎的机器翻译基准测试BLEU(双语评估替补)提供了一种简单的数值测试,以评估谷歌翻译在不同语言组合

-

2.14.2. 单词错误率(WER)基准测试对语音助手(如亚马逊的Alexa和苹果的Siri)的错误率显著下降起到了重要作用

2.15. 一个真正有效的基准测试可能因促成模型巨大的性能提升而使自己落伍,因为模型已经超越了该基准测试所设定的标准

- 2.15.1. 许多流行的技术性能基准测试的性能饱和

2.16. 尽管基准测试推动了大语言模型的改进,使其在现实场景中表现出越来越令人印象深刻的性能,但现实生活中的多项选择题从来都不像考试中出现的那样整齐有序

2.17. 基准测试有助于研究人员和开发者探索与AI相关的诸多问题,并更深入地了解AI系统的能力