作者:陈涛、徐志远

本文整理自 2025 年云栖大会阿里云智能集团产品专家陈涛、阿里云智能集团飞天实验室资深产品专家徐志远带来的主题演讲《EventBridge for AI ETL 全新发布,事件驱动重塑 AI 应用数据全链路》

前言

在最近的 2025 云栖大会上,一个核心议题引发了开发者和技术决策者的广泛关注:在生成式 AI(Generative AI)浪潮下,如何高效、可靠地管理和处理日益复杂的数据,以充分释放 AI 的潜能?传统的数据处理链路,尤其是 ETL(提取、转换、加载)过程,正面临着前所未有的挑战。

“一个简单的数据集成任务,开始时总是轻松愉快的,但随着业务扩展,数据源越来越多,格式越来越乱,整个数据链路就会变得一团糟。”陈涛在演讲中指出了当前 AI 数据处理的普遍困境。扩展难、运维难、稳定性差,这三大挑战已成为制约 AI 应用创新和落地的关键瓶颈。

针对这些痛点,在大会期间,阿里云重磅发布了事件驱动 AI ETL 新范式,其核心产品 EventBridge 通过深度集成 AI 能力,为开发者提供了一套革命性的解决方案,旨在彻底改变 AI 时代的数据准备与处理方式。

双向赋能:当 EventBridge 遇见 AI

此次发布的核心,是 EventBridge 与 AI 能力的双向深度融合,带来了“针对 AI 领域的数据处理/准备的全新链路升级”(EventBridge for AI Data)和“如何用 AI 来做数据处理 ETL”(AI for EventBridge Data)两大创新模式,从根本上解决了数据链路的复杂性问题。

模式一:EventBridge for AI Data — 针对 AI 领域的数据处理/准备的全新链路升级

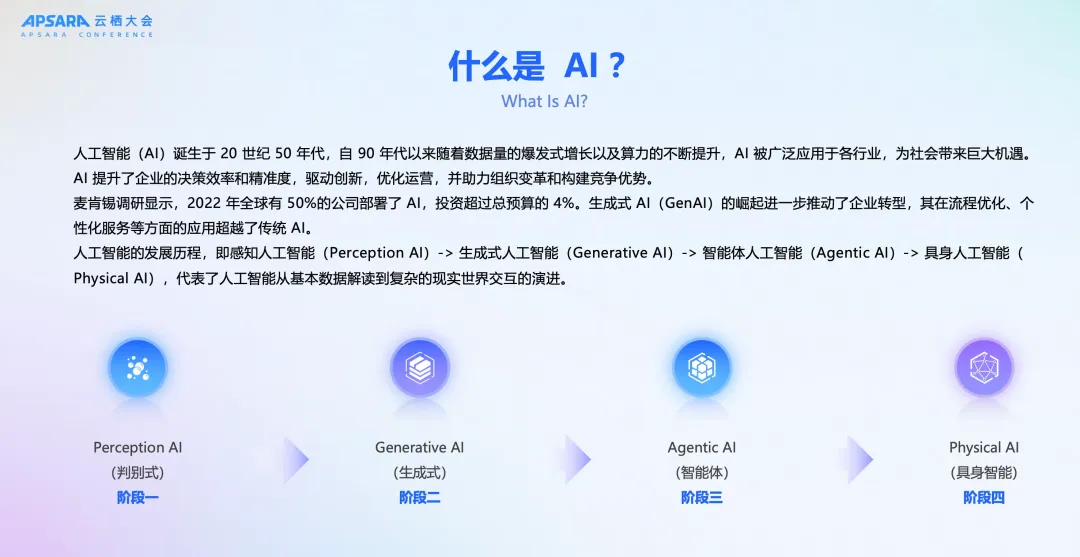

人工智能的发展历程,本身就是一部与数据共舞的史诗。从最初依赖于规则和符号逻辑的“判别式 AI”,到如今基于海量数据训练、能够理解和生成复杂内容的“生成式 AI”(Generative AI),再到未来能够自主规划、执行复杂任务的“智能体 AI”(Agentic AI),乃至最终与物理世界深度融合的“具身 AI”(Physical AI),每一个阶段的跃迁,都伴随着数据处理能力和数据利用效率的指数级提升。可以说,谁掌握了高效、智能的数据处理能力,谁就把握住了通往未来智能世界的脉搏。

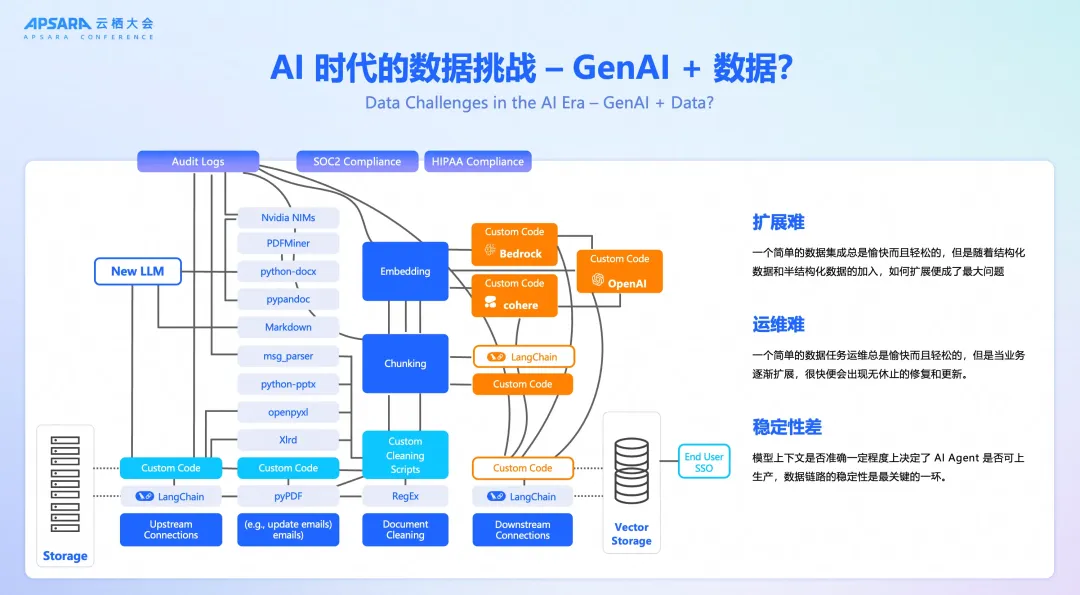

然而,通往智能未来的道路并非一片坦途。在 AI,特别是以大语言模型(LLM)为代表的生成式 AI 应用日益普及的今天,我们正面临着前所未有的数据挑战。数据的来源空前广泛,从企业内部的 CRM、ERP 系统,到物联网(IoT)设备上传感器的实时读数,再到互联网上的文本、图片、视频等海量非结构化信息,数据呈现出爆炸式增长和高度异构化的特征。传统的、为处理结构化数据而生的数据处理架构,在应对这场“数据海啸”时,显得捉襟见肘,力不从心。

开发者和企业普遍陷入了数据处理的“三重困境”:

- 扩展之困:业务的快速迭代要求数据管道能够灵活、快速地接入新的数据源。然而,传统的数据集成方式往往涉及复杂的点对点连接和定制化开发,每增加一个数据源或数据格式,都可能需要对整个数据链路进行重构,扩展性差,响应速度慢,严重制约了业务的创新步伐。

- 运维之难:随着数据处理逻辑日益复杂,数据管道变得越来越长、越来越脆弱,如同一个“黑箱”。任何一个环节的微小故障,都可能引发“蝴蝶效应”,导致整个链路的瘫痪。问题的排查、修复和系统的更新,都变成了极其耗时耗力的运维噩梦。

- 稳定之痛:对于 AI 应用而言,“垃圾进,垃圾出”(Garbage In, Garbage Out)的原则尤为凸显。输入数据的质量、实时性和上下文的准确性,直接决定了 AI 模型的输出质量和应用的可靠性。一个不稳定、高延迟的数据管道,是悬在所有生产级 AI 应用头上的“达摩克利斯之剑”。

面对 AI 时代的“数据新常态”和上述严峻挑战,我们迫切需要一种全新的数据处理范式。它必须是灵活的、可扩展的、实时的、智能的,能够像人体的神经网络一样,敏锐地感知、高效地传输并智能地处理来自四面八方的“数据信号”。

那么,如何才能优雅地解决这些棘手的数据挑战呢?这就引出了我们今天的主角——EventBridge。它将作为我们重塑 AI 应用数据全链路的核心武器。

EventBridge 带来的并非对传统 ETL(提取、转换、加载)工具的简单改良,而是一次彻底的范式革命。它以事件驱动架构(Event-Driven Architecture, EDA)为核心理念,将先进的 AI 能力深度融入数据处理的全链路,致力于为开发者和企业提供一个专为 AI 应用设计的、端到端的、智能化的数据处理中间件。

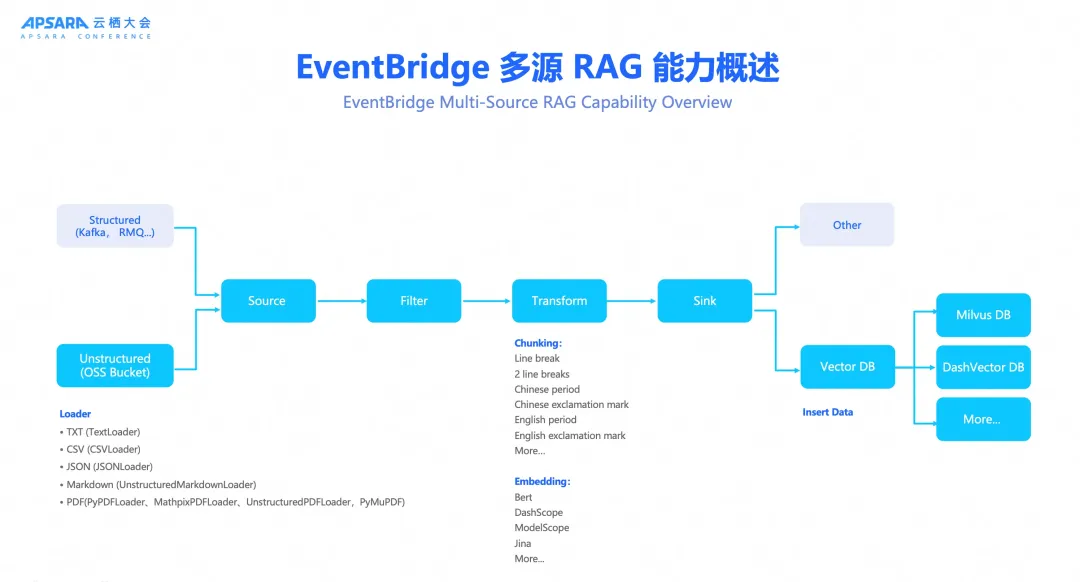

检索增强生成(RAG)是当前提升大模型效果的关键技术,但其数据准备流程——从多源异构数据中提取、清洗、切块、向量化再到入库——过程繁琐且易错。EventBridge 通过全新的 AI ETL 能力,将这一流程彻底自动化。

开发者现在可以通过简单的白屏化配置,实现:

- 多源接入:无缝对接对象存储(OSS)、消息队列(Kafka, RocketMQ)、数据库等多种数据源。

- 智能处理:自动化完成文档解析(Loader)、文本切分(Chunking)和向量化(Embedding)。

- 一键入库:将处理好的高质量向量数据,直接加载到主流的向量数据库(如 DashVector, Milvus)中。

陈涛在演讲中强调“我们希望达到的效果是一气呵成”,“开发者无需再为 RAG 的数据管道编写和维护复杂的代码,可以将精力完全聚焦在 AI 应用本身的创新上。”

模式二:AI for EventBridge Data — 如何用 AI 来做数据处理 ETL

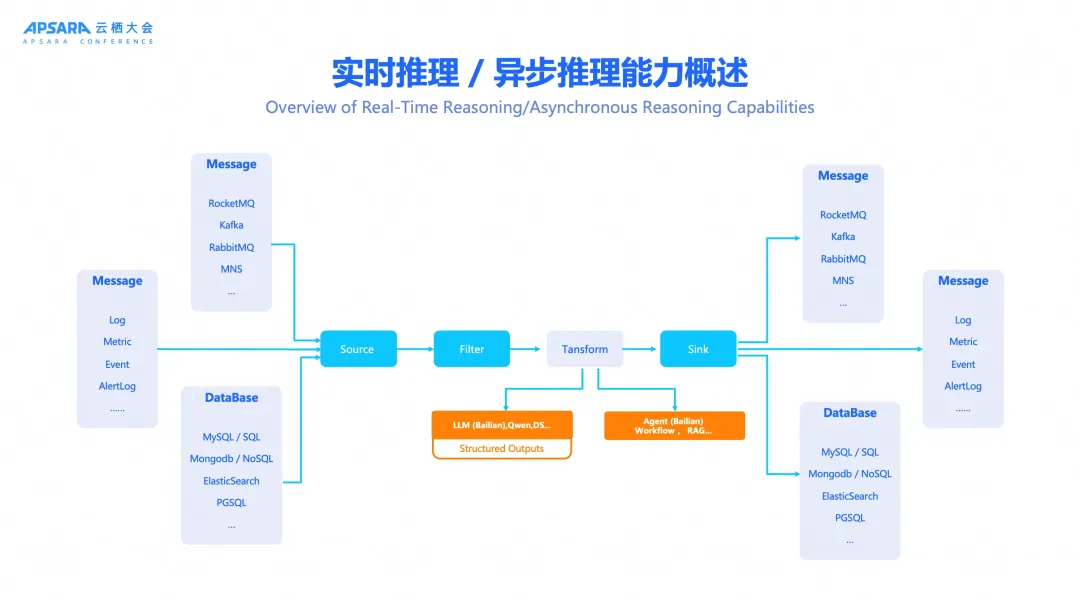

如果说模式一是为 AI “输送弹药”,那么模式二就是将 AI 的“智慧”直接注入数据转换(Transform)环节。传统的 ETL 工具在面对非结构化、语义化的数据处理需求时常常力不从心,而这正是大语言模型的用武之地。

通过在 EventBridge 中原生集成百炼大模型服务,开发者现在可以在数据流中直接调用 AI,完成许多过去需要上千行代码才能实现的复杂任务。

让我们来看一个非常经典的场景:地址信息标准化。用户在前端页面输入一个地址,格式五花八门。而后端系统为了入库和后续分析,需要将其解析成标准的“省-市-区-街道-邮编”格式。在过去,要实现这个功能,工程师需要编写上千行代码,处理各种异常情况,维护一个庞大的地址库,过程非常痛苦。

但是现在,有了大语言模型,一切都变得简单了。

在 EventBridge 中,我们内置了实时和异步推理的能力。在“转换”步骤中,可以直接调用大语言模型(比如通义千问或百炼平台上的模型),甚至是更复杂的 AI Agent。更重要的是,EventBridge 提供了强大的“结构化输出”能力,确保 AI 的输出是稳定、可靠、可被机器直接解析的格式,而不是随意的自然语言文本。

“结构化输出”是让大模型在企业级应用中真正落地的关键一环。

比如,我们想让模型分析一句用户评论的情感。我们不希望它返回“我觉得这句话是积极的”这样模棱两可的文本,而是希望它直接返回一个 JSON 对象,清晰地标明 sentiment 是“积极”,summary 是“产品设计和性能出色”。EventBridge 产品化地支持了这一能力。我们优先利用模型自身的 JsonSchema 功能;当模型不支持时,我们通过巧妙的提示词注入技术,同样能确保稳定、可靠的结构化输出。这极大地降低了在 ETL 流程中使用 AI 的门槛。

更关键的是,EventBridge 解决了大模型输出不稳定的核心痛点。通过内置的结构化输出(Structured Output) 能力,平台确保 AI 的每一次处理结果都以稳定、可靠的 JSON 格式返回,让数据转换告别“开盲盒”式的不确定性,为企业级应用的稳定性提供了坚实保障。

生态协作:百炼+EventBridge,一站式 RAG 解决方案

此次发布的另一大亮点是阿里云产品生态的强大协同能力。阿里云飞天实验室资深产品专家徐志远在演讲中详细介绍了百炼大模型服务平台如何基于 EventBridge,为企业提供一站式的 RAG 解决方案。

“要做好 RAG,企业面临着知识管理复杂、搜索精度差、模型易产生幻觉等一系列痛点,”徐志远指出,“百炼 RAG 的核心目标,就是实现可管理、可调优、可干预、可观测、可运营。”

而实现这一目标的关键,在于打通复杂的数据链路。通过“百炼 + EventBridge”的强强联合,企业可以快速构建起强大的、自动化的多源 RAG 数据管理能力。EventBridge 负责解决前端所有复杂、异构数据的接入和处理问题,而百炼则专注于后端 RAG 效果的调优和应用构建,让企业可以将复杂的数据工程问题放心地交给云平台,真正实现对 AI 应用的专注。

结论:迈向更简约、更健壮的数据架构

阿里云 EventBridge 此次发布的事件驱动 AI ETL 新范式,不仅是对传统数据处理流程的一次重大革新,更是对未来 AI 应用开发模式的一次深刻洞察。它通过将事件驱动架构的灵活性与大模型的智能性完美结合,为开发者提供了一条通往更智能、更简约、更可靠数据处理的清晰路径。

随着 AI 技术的日益成熟,数据无疑将成为未来创新的核心引擎。如何高效、优雅地驾驭数据,将直接决定企业在智能化浪潮中的竞争力。EventBridge 所开启的 AI ETL 新时代,无疑为所有希望在 AI 领域大展拳脚的开发者和企业,提供了一件不可或缺的利器。

我们邀请您探索 EventBridge 的全新功能,并加入我们的技术社区,与我们共同定义和构建 AI 数据处理的未来。

EventBridge for AI ETL 解决方案已上线,点击此处,欢迎部署体验!