摘要

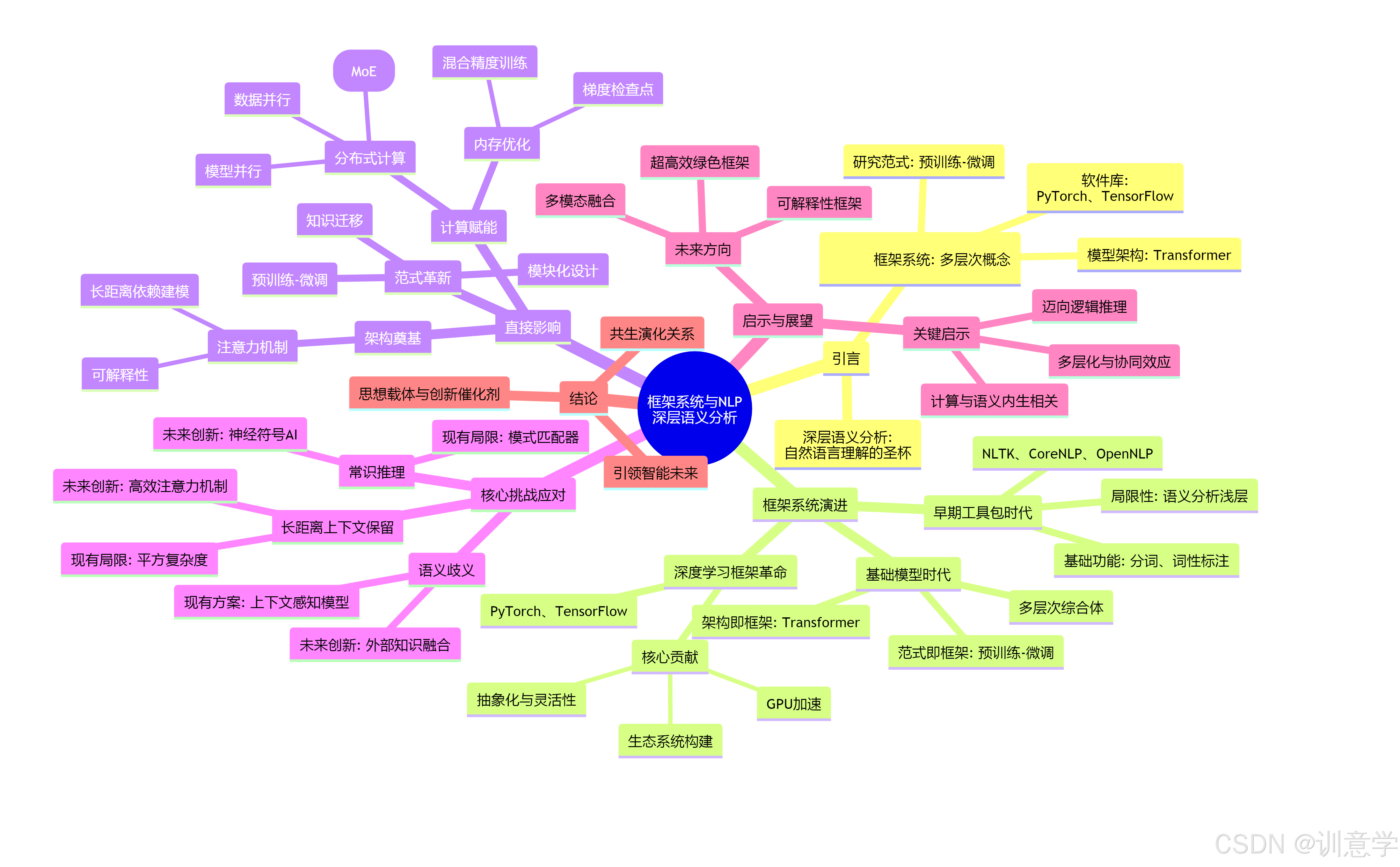

本报告旨在深入探讨框架系统(Frameworks)在推动人工智能(AI)领域中自然语言处理(NLP)的深层语义分析(Deep Semantic Analysis)方面所扮演的关键角色、产生的影响以及带来的深刻启示。报告指出,“框架”的概念已从传统的软件工具包(如PyTorch、TensorFlow)扩展至涵盖了基础模型架构(如Transformer)和研究范式(如预训练-微调)。报告系统性地分析了这些框架如何在架构设计、计算效率和研究范式三个层面,根本性地提升了机器对语言深层含义的理解能力,并探讨了框架创新如何帮助应对语义歧义、上下文保留等核心挑战。最后,报告总结了框架架构演进带来的多层次化、计算与语义深度内生关联以及从模式识别迈向逻辑推理等关键启示,并展望了其未来发展方向。

1. 引言:深层语义分析时代的基石

建立在过去数十年中不断演进的框架系统之上。就是自然语言处理(NLP)是人工智能领域皇冠上的明珠,其终极目标之一是让机器能够像人类一样理解和运用语言。深层语义分析,作为这一宏大目标的“圣杯”,旨在超越词汇和句法层面,深入探究文本背后隐藏的意图、关系、情感和常识知识 。随着大型语言模型(LLMs)在2025年持续展现出惊人的能力,我们必须认识到,这些成就并非凭空而来,而

这些框架系统,不仅包括献出底层计算支撑和高级API的软件库(如PyTorch和TensorFlow),更囊括了那些定义了模型构建方式的革命性架构(如Transformer)以及改变了研究和应用范式的训练方法(如BERT的预训练-微调模式)。本报告将系统性地剖析这些多层次的框架系统,揭示它们如何成为推动NLP深层语义分析能力实现跨越式发展的核心引擎。

2. 框架系统的演进:从工具到生态

框架系统在NLP领域的演进,清晰地勾勒出技术发展的脉络,每一次变革都为更深层次的语义理解铺平了道路。

2.1. 早期工具包时代:奠定基础

在深度学习浪潮之前,NLP的研究与应用严重依赖于一套成熟的工具包和框架,如自然语言工具包(NLTK)、斯坦福大学的CoreNLP套件以及Apache的OpenNLP等 。这些框架提供了包括分词、词性标注、句法分析和命名实体识别在内的基础功能。它们将困难的语言学算法封装起来,降低了开发者进入NLP领域的门槛。然而,这些基于规则和传统统计机器学习的框架,其语义分析能力相对“浅层”,难以捕捉复杂的上下文依赖和深层语义关系,为后续深度学习框架的出现埋下了伏笔。

2.2. 深度学习框架革命:赋能复杂模型

PyTorch和TensorFlow的崛起,标志着NLP进入了一个全新的时代 。这两大框架的核心贡献在于:

- 抽象化与灵活性:它们提供了高层次的API,允许研究人员用简洁的代码构建和训练极其复杂的神经网络,将开发者从繁琐的底层细节中解放出来 。

- GPU加速:它们原生支持GPU加速,极大地缩短了训练大型模型所需的时间,使得曾经不切实际的模型规模成为可能 。

- 生态系统构建:围绕这两大框架,一个庞大而活跃的开源社区迅速形成,贡献了海量的预构建模型、教程和应用,极大地加速了NLP领域的创新迭代。

正是这些深度学习框架,为后来主导NLP领域的Transformer、BERT和GPT等模型的诞生提供了必需的“土壤”和“养料” 。

2.3. 基础模型时代:“框架”概念的升华

进入2020年代,尤其是2025年的今天,“框架”的内涵进一步扩展。它不再仅仅指代软件工具。

- 架构即框架:Transformer架构本身已成为一种概念框架 。其核心的自注意力机制(Self-Attention)提供了一种全新的、极其强大的方式来建模序列数据中的长距离依赖关系,这正是深层语义理解的关键。

- 范式即框架:以BERT为代表的“预训练-微调”(Pre-training and Fine-tuning)范式,也成为了一种主导性的框架 。该范式依据在海量通用语料上进行预训练,让模型学习到丰富的语言知识,然后凭借在特定任务上进行微调,即可高效地搭建卓越的性能。这种模式极大地提升了模型在各种语义任务上的表现,并降低了应用的门槛。

因此,现代NLP的框架系统是一个多层次的综合体:底层是PyTorch/TensorFlow等计算框架,中层是Transformer等模型架构框架,顶层则是预训练-微调等应用范式框架。它们协同作用,共同推动着深层语义分析能力的边界。

3. 框架系统对深层语义分析的直接影响

框架架构的演进并非仅仅是工程效率的提升,它从根本上决定了我们能够达到的语义分析深度。

3.1. 架构奠基:注意力机制重塑上下文理解

深层语义分析的核心在于对上下文的精准捕捉。传统RNN或LSTM模型在处理长序列时会面临梯度消失或信息瓶颈问题。Transformer架构,作为一种被主流AI框架广泛支持的设计蓝图,凭借其核心的注意力机制(Attention Mechanism) 彻底改变了这一局面 。

构建深层语义理解的架构基石 。此外,注意力权重还为模型决策提供了某种程度的可解释性,让我们可能窥见模型在进行语义判断时的“思考过程” 。就是注意力机制允许模型在处理一个词时,能够同时“关注”到输入序列中的所有其他词,并根据相关性计算权重 。这意味着模型可能直接建立任意两个词之间的语义依赖关系,无论它们在文本中的距离有多远。这种能力对于解决复杂的语义依赖、指代消解和长距离上下文理解至关重要,

3.2. 计算赋能:让“深”成为可能

纸上谈兵。AI框架通过以下方式提供了这种关键的计算赋能:就是深层语义分析能力的提升与模型规模的扩大和复杂度的增加密切相关。没有强大的计算支持,再精妙的架构也只

分布式计算:为了训练参数量动辄数千亿甚至万亿的大型语言模型,单一计算设备已远远不够。AI框架内置了成熟的分布式计算技术,如数据并行(Data Parallelism) 和 模型并行(Model Parallelism) 。资料并行将训练数据切分到多个设备上,同时训练模型的多个副本;模型并行则将过大的模型本身切分到多个设备上 。这些技术使得训练巨型模型成为现实,而更大的模型通常能涌现出更强的语义理解和推理能力 。进入2025年,诸如专家混合(Mixture of Experts, MoE) 等更高效的分布式架构也被集成到框架中,进一步优化了训练和推理效率 。

内存优化:模型规模的增长带来了巨大的内存压力。框架设计中的内存优化技术,对于提升语义分析的深度和广度至关重要。例如,梯度检查点(Gradient Checkpointing) 技术通过在反向传播时重新计算部分激活值,而不是存储所有中间结果,从而以少量计算开销换取显著的内存节省(可高达50%甚至更多),使得在有限的硬件上能够训练更大、更深的模型 。其他技术如混合精度训练、量化和剪枝等,也都是框架层面提供的关键优化,它们共同降低了探索深层语义模型的门槛 。

3.3. 范式革新:加速知识的获取与迁移

预训练-微调范式的成功,离不开框架提供的支持。框架使得加载一个庞大的预训练模型(如BERT或GPT),并轻松地在其之上添加针对特定下游任务(如情感分析、问答、语义角色标注)的自定义层成为可能 。这种模块化和可迁移性,极大地加速了研究和应用落地。研究人员无需每次都从零开始训练一个巨大的模型,而是可以站在巨人的肩膀上,将预训练模型中蕴含的丰富通用语言知识,高效地迁移到具体的语义分析任务中,从而在许多基准测试中取得了最先进的结果 。

4. 通过框架创新应对深层语义分析的核心挑战

尽管取得了巨大进展,深层语义分析仍面临诸多挑战。框架系统的持续创新正致力于攻克这些难题。

4.1. 挑战一:语义歧义(Semantic Ambiguity)

NLP长期以来的核心挑战 。就是一词多义和语境依赖是自然语言中普遍存在的歧义来源,也

- 现有框架的贡献:基于Transformer架构的上下文感知模型(如BERT),其核心能力就是利用注意力机制动态地根据上下文生成词的表示 。这使得模型能够有效地区分同一个词在不同语境下的含义,例如“bank”在“river bank”(河岸)和“investment bank”(投资银行)中的不同。

- 未来的框架创新:2025年的研究趋势显示,单纯依赖文本内部上下文有时仍不足够。未来的框架设计正朝着更便捷地融合外部知识的方向发展,例如无缝集成知识图谱或外部数据库,为模型提供消解歧义所需的背景和常识知识 。同时,也出现了像AICMA这样的概念框架,它利用现有的大模型框架来识别和修正AI生成内容中的歧义,这代表了从理解歧义到主动管理歧义的进步 。

4.2. 挑战二:长距离上下文保留(Long-Context Retention)

在处理长篇文档、多轮对话或复杂推理任务时,模型必须能够有效保留和利用距离遥远的信息。

- 现有框架的贡献:Transformer架构在理论上解除了RNN的序列处理瓶颈,但其注意力机制的计算复杂度与序列长度的平方成正比,限制了可处理的上下文长度。

- 未来的框架创新:框架层面的创新正集中于开发更高效的注意力机制变体和优化的内存管理策略。例如,稀疏注意力、线性注意力等算法的提出和框架集成,旨在在保持性能的同时,降低长序列处理的计算和内存成本。同时,前文提到的梯度检查点等内存优化技术,也直接服务于扩展模型的上下文窗口,从而增强其对长篇文本的深层语义理解能力 。

4.3. 挑战三:常识推理与深层理解(Commonsense Reasoning)

当前的深度学习模型本质上是强大的模式匹配器,但在进行需要常识和逻辑推理的深层理解时仍显不足 。

- 现有框架的局限:主流的深度学习框架主要为端到端的神经网络训练而设计,对于融合符号逻辑等非神经网络方法支持不足。

- 未来的框架创新:这是一个前沿领域。研究界正在积极探索神经符号AI(Neuro-symbolic AI) ,即结合神经网络的感知能力和符号系统的推理能力 。未来的AI框架必须具备更好的互操作性,能够无缝集成和协同优化这两种异构的计算范式。此外,一些更具前瞻性的概念,如量子语义框架,也被提出用于探索消除经典模型难以处理的复杂歧义和推理问题,这预示着未来框架可能需要支持全新的计算原理 。

5. 启示与未来展望

框架系统对深层语义分析的影响带来了几点深刻的启示:

- 启示一:“框架”的多层化与协同效应一个包含了底层计算库、中层模型架构和顶层研究范式的多层次概念。深层语义分析的每一次突破,都源于这几个层面创新之间的协同共振。就是。我们必须认识到,“框架”

- 启示二:计算能力与语义深度内生相关。语义分析的深度,在很大程度上受限于我们能够高效驾驭的计算规模。框架在分布式计算和内存优化方面的创新,并非单纯的工程优化,而是解锁更深层次语义理解能力的根本前提。

- 必然趋势就是启示三:从统计模式迈向逻辑推理。要实现真正的人类水平的语言理解,模型必须超越统计相关性,具备逻辑推理和运用常识的能力。未来的框架系统必须演进以支持更加混合、更加艰难的智能形态。

展望未来,AI框架将在以下几个方向持续演进,以支持更强大的深层语义分析:

- 多模态融合框架:协助无缝整合文本、图像、声音等多种信息来源,构建更完整、更丰富的语义空间 。

- 可解释性与可信赖框架:在框架层面内置更多工具和特性,以增强模型决策过程的透明度和可解释性,这对于在关键领域应用深层语义分析至关重要 。

- 超高效与绿色框架:随着模型规模持续增长,对计算资源和能源的消耗也日益严峻。开发更高计算效率、更低能耗的框架将是实现AI可持续发展的关键。

6. 结论

框架框架在人工智能对自然语言的深层语义分析中,扮演了远超“工具”的角色。它们是思想的载体、创新的催化剂和能力的放大器。从提供基础算法的早期工具包,到赋能大规模并行计算的深度学习平台,再到定义了新一代AI模型DNA的Transformer架构和预训练范式,框架系统的每一次演进都深刻地重塑了大家探索语言奥秘的方式和边界。

截至2025年,框架系统与深层语义分析已经形成了一种共生演化的关系:对更深层次理解的追求,驱动着框架向更高效、更强大、更融合的方向发展;而框架的每一次突破,又反过来为解锁新的语义分析能力给予了坚实的阶梯。未来,这一共生关系将继续作为人工智能领域最激动人心的主线之一,引领我们走向更加智能的未来。