《神经网络与深度学习:从理论到CIFAR-10实战》读书报告

一、引言

在人工智能蓬勃发展的当下,神经网络作为机器学习领域的核心技术,已在计算机视觉、自然语言处理等诸多领域展现出强大的能力。本次读书报告将围绕神经网络的理论基础与实践应用展开,结合经典的CIFAR-10图像分类任务,深入剖析神经网络的工作原理与工程实现。

二、神经网络理论基础

(一)感知机模型

感知机是神经网络的基础单元,它模拟生物神经元的工作方式,通过对输入信号的加权求和并经过激活函数处理,输出一个二值化的结果。虽然感知机仅能解决线性可分问题,但它为后续多层神经网络的发展奠定了理论基石。

(二)多层神经网络

多层神经网络由输入层、隐藏层和输出层组成。隐藏层的引入使得网络具备了拟合非线性函数的能力。在训练过程中,通过反向传播算法计算损失函数对各层参数的梯度,再利用梯度下降法更新参数,从而不断优化网络性能。

(三)卷积神经网络(CNN)

卷积神经网络是专为图像处理设计的神经网络架构,它包含卷积层、池化层和全连接层等关键组件。

- 卷积层:通过卷积核在输入图像上的滑动,提取局部特征,如边缘、纹理等。卷积操作具有参数共享和局部连接的特点,大幅减少了网络参数数量,同时保留了图像的空间结构信息。

- 池化层:对卷积层输出的特征图进行下采样,降低特征维度,减少计算量,同时增强网络的平移不变性。常见的池化操作有最大池化和平均池化。

- 全连接层:将前面提取的特征进行整合,输出最终的分类结果。

三、CIFAR-10实战分析

(一)数据集介绍

CIFAR-10数据集包含60000张32×32的彩色图像,分为10个类别,每个类别有6000张图像,其中训练集50000张,测试集10000张。该数据集是图像分类任务的经典 benchmark,适合用于验证神经网络模型的性能。

(二)模型构建与训练

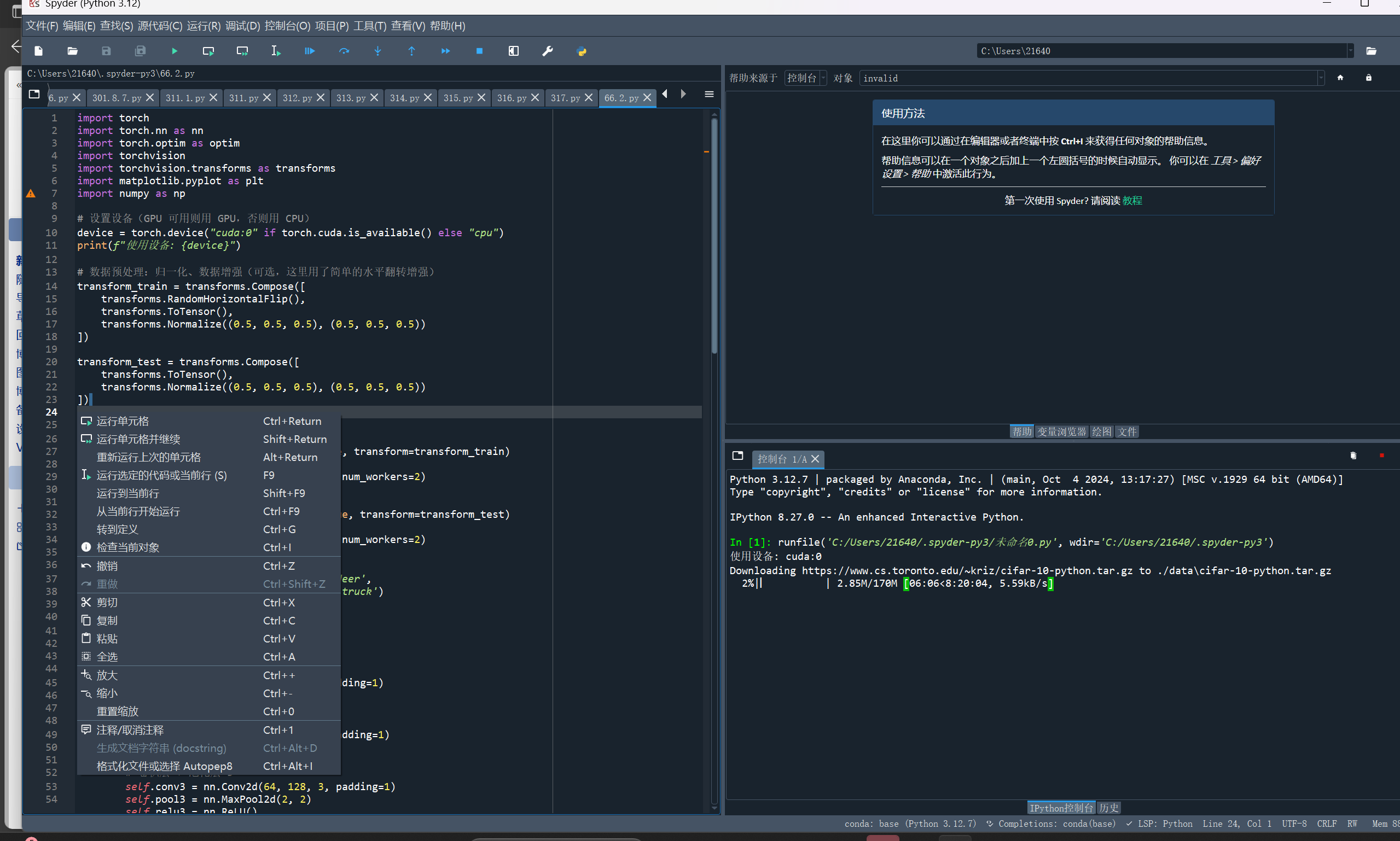

基于PyTorch框架构建卷积神经网络模型,主要步骤如下:

- 数据预处理:对图像进行归一化、随机水平翻转等操作,增强数据的多样性,提升模型的泛化能力。

- 网络架构设计:采用3个卷积层+池化层的组合,后接2个全连接层,并引入Dropout层防止过拟合。

- 损失函数与优化器:使用交叉熵损失函数衡量分类误差,选择随机梯度下降(SGD)优化器,并结合学习率调度器动态调整学习率。

- 模型训练与评估:经过多个epoch的训练,在测试集上评估模型准确率,同时分析每个类别的分类性能。

(三)实验结果与分析

训练完成后,模型在CIFAR-10测试集上可达到约85%的准确率。通过对每个类别准确率的分析,发现模型对“plane”“car”等类别识别准确率较高,而对“bird”“cat”等类别准确率相对较低,这可能是因为这些类别图像的特征区分度较小。

四、总结与展望

神经网络凭借其强大的非线性拟合能力,在图像分类等任务中取得了显著成果。通过对CIFAR-10数据集的实战,我们深入理解了卷积神经网络的工作流程与优化方法。未来,随着网络架构的不断创新(如残差网络、注意力机制等)以及硬件算力的提升,神经网络在计算机视觉领域的应用将更加广泛,性能也将进一步提升。