🧠 一、SimAM 的基本思想

SimAM(Simple Attention Module) 是一种无参数的注意力机制(即不增加可学习参数),发表于

📝 SimAM: A Simple, Parameter-Free Attention Module for Convolutional Neural Networks

(IEEE/CVF CVPR 2021)

它的核心思想是:

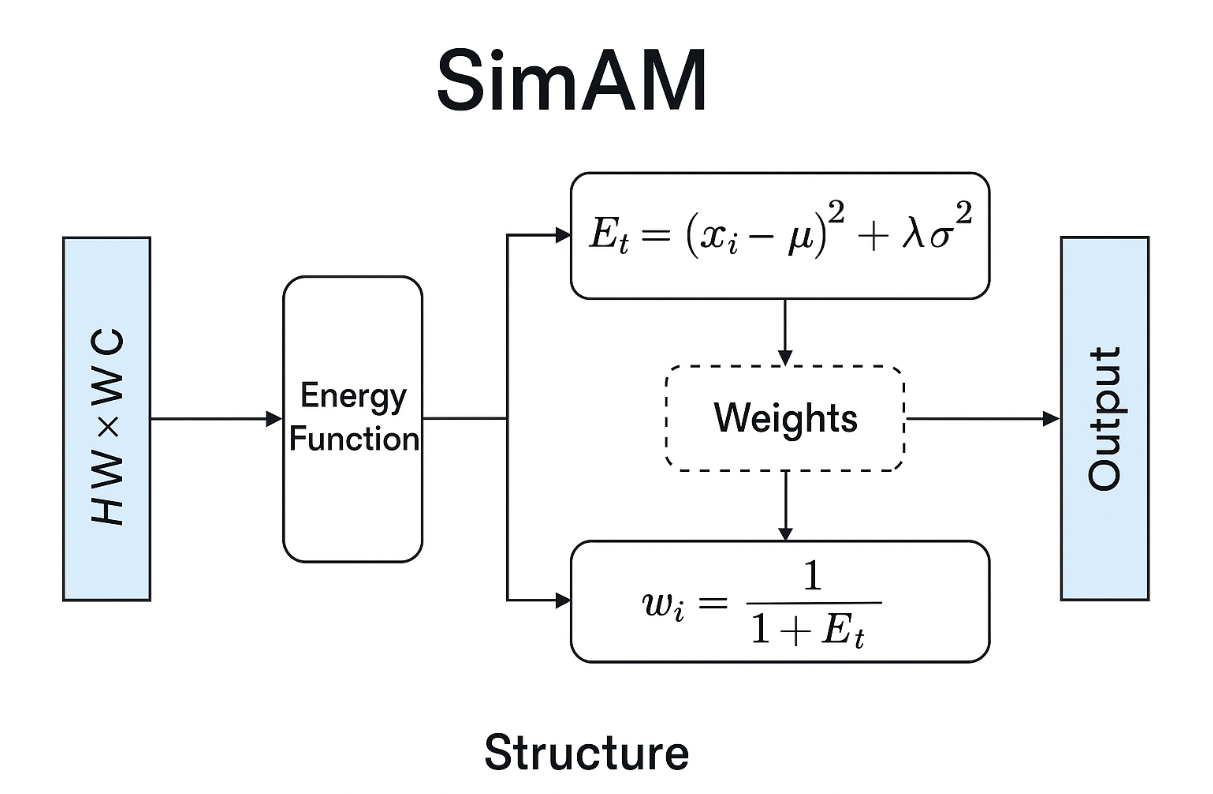

通过能量函数(Energy Function)来衡量每个神经元的重要性。

与常见的 SE、CBAM、ECA 等注意力不同,SimAM 不使用卷积或全连接层,而是**通过计算每个神经元与其邻域之间的差异性(信息独特性)**来决定注意力权重。

⚙️ 二、SimAM 的核心原理

SimAM 的核心来自于一个“神经元能量”模型。

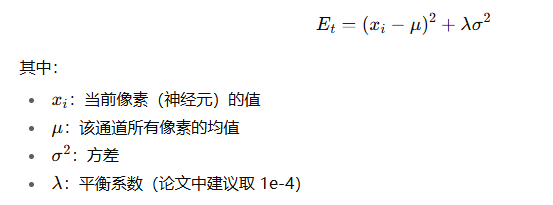

对于卷积特征图中任意一个通道内的某个神经元 xix_ixi,SimAM 通过一个能量函数来衡量其“信息量”:

![image]()

SimAM 假设:

神经元越“独特”(与均值差异越大),则其能量越低、重要性越高。

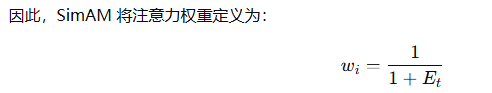

![image]()

即能量越低的神经元(信息更突出的区域)被赋予更高的注意力权重。

🧩 三、SimAM 的结构特点

| 特征 |

说明 |

| 🪶 无参数 |

不使用卷积或全连接层,不增加模型参数 |

| ⚡ 轻量高效 |

几乎不增加计算量,适合嵌入到轻量化模型 |

| 🔍 全局通道内注意力 |

对每个通道独立计算,不混合通道信息 |

| 🧮 基于能量函数 |

理论基础清晰,计算简洁 |

💻 四、SimAM 的简单实现(PyTorch版)

🔬 五、与其他注意力机制的对比

| 模块 |

参数量 |

计算复杂度 |

特点 |

| SE (Squeeze-Excitation) |

有参数 |

高 |

通过全连接建模通道关系 |

| CBAM |

有参数 |

较高 |

通道+空间双重注意力 |

| ECA |

少量参数 |

低 |

1D卷积近似通道关系 |

| SimAM |

✅ 无参数 |

✅ 极低 |

基于能量模型的轻量注意力 |

🧭 六、在YOLO中的应用场景

在 YOLOv5 / YOLOv8 / YOLOv11 等模型中,SimAM 常用于:

例如,在 yolo11.yaml 中添加:

📈 七、总结

| 项目 |

内容 |

| 模块名称 |

SimAM(Simple Attention Module) |

| 核心思想 |

通过能量函数计算神经元重要性 |

| 参数量 |

0(完全无参数) |

| 优点 |

轻量、高效、易嵌入、适合小模型 |

| 适用场景 |

YOLO、ResNet、MobileNet等轻量网络结构中 |

是否希望我帮你画一个 SimAM 的结构示意图(展示输入特征 → 能量计算 → 权重生成 → 输出)

![image]()