决策树(Decision Tree)是一种常见的非参数监督学习算法,可用于分类和回归任务。它通过构建树状模型,模拟人类决策过程,将数据根据不同的特征进行分割,最终在树的叶子节点得出结论。

1. 决策树的结构

一个完整的决策树由以下几个部分构成:

- 根节点(Root Node): 代表整个数据集的起点。

- 内部节点(Internal Node): 代表一个特征上的“测试”或“决定”,根据该特征的不同取值将数据分流到不同的子节点。

- 分支(Branch): 连接节点之间的路径,代表一个决策规则或测试结果。

- 叶子节点(Leaf Node): 树的末端,代表最终的分类结果或回归预测值。

2. 工作原理

决策树的构建过程基于一种分而治之的贪心策略,通过递归地将数据集分割成越来越纯的子集。核心步骤如下:

- 特征选择: 从所有可用特征中,选择一个最佳特征作为分割依据。常用的选择标准包括信息增益(Information Gain)、信息增益率(Gain Ratio)和基尼不纯度(Gini Impurity)。

- 递归构建: 选定特征后,根据其值将数据集分割成子集。对每个子集,递归地重复第一步和第二步,直到满足停止条件。

- 停止条件: 决策树停止生长的常见条件包括:

- 节点上的所有数据都属于同一类别。

- 所有特征都已用完。

- 节点中的数据样本数量低于某个预设阈值。

- 剪枝(Pruning): 为了防止过拟合,通常会在树构建完成后进行剪枝,即删除一些不必要的叶子节点或子树,以提高模型的泛化能力。

3. 优点和缺点

优点

- 直观易理解: 决策树的结构类似流程图,可以被清晰地可视化,易于人类理解和解释。

- 无需数据预处理: 决策树对数据的缩放和归一化不敏感,并且可以自然处理缺失值。

- 能处理多种数据类型: 可以同时处理分类(离散值)和回归(连续值)问题。

- 无参数假设: 作为一种非参数方法,决策树不依赖于特定的数据分布假设。

缺点

- 容易过拟合: 如果决策树的深度过大,它可能会过度拟合训练数据中的噪声,导致泛化能力下降。

- 对数据敏感: 训练数据中微小的变化可能导致树的结构发生巨大改变,从而导致模型不稳定。

- 最优解难寻: 由于采用贪心算法,决策树在每个分割点只寻找局部最优解,不能保证找到全局最优解。

4. 经典算法

- ID3: 使用信息增益作为分裂准则,倾向于选择有更多取值的特征。

- C4.5: ID3的改进版,使用信息增益率作为分裂准则,解决了ID3偏向多值特征的问题,并能处理连续值和缺失值。

- CART(分类与回归树): 使用基尼不纯度作为分裂准则(用于分类),或使用均方误差(用于回归),可以生成二叉树。

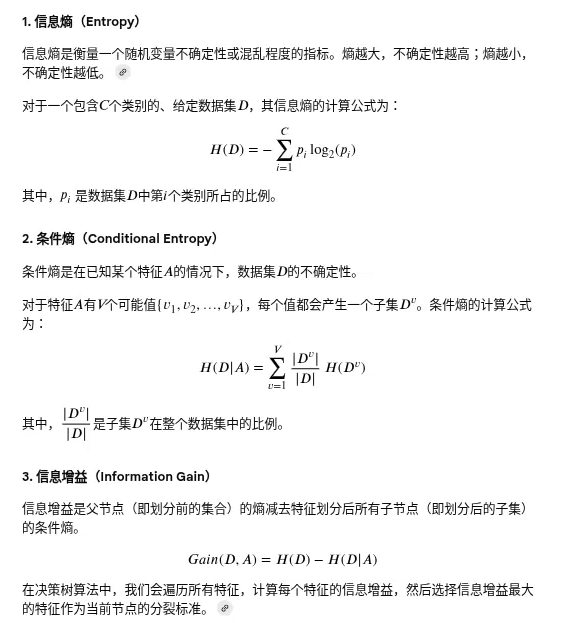

信息增益(Information Gain)是决策树算法中用来选择最佳特征进行节点划分的重要标准。它的核心思想是,在得知一个特征的信息之后,能减少多少不确定性。

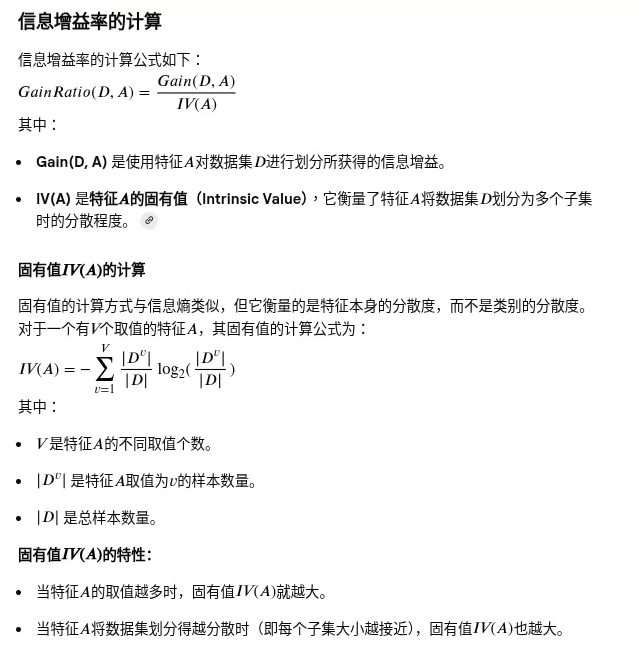

信息增益率(Information Gain Ratio):决策树算法C4.5中用于解决信息增益偏向于选择取值较多特征的问题而提出的。它是在信息增益的基础上,通过引入一个惩罚因子来修正信息增益的不足。

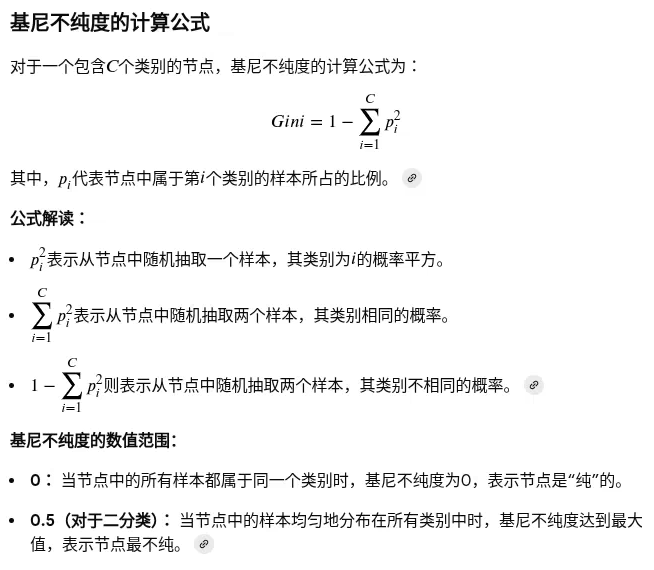

基尼不纯度(Gini Impurity):一种用于决策树算法(特别是CART算法)中的分类指标,用来衡量一个节点中样本集合的不确定性或混乱程度。它的目标是找到一个特征和分割点,使得划分后的子节点集合的基尼不纯度最低,从而获得“最纯”的划分。

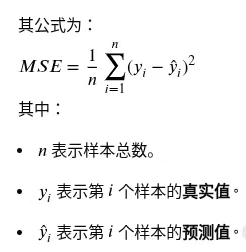

均方误差:

均方误差衡量模型精度: MSE值越小,代表模型预测值与真实值越接近,模型的准确性越高。

应用场景

决策树由于其直观性和有效性,在多个领域都有广泛应用:

- 客户流失预测: 通过分析客户行为数据,预测哪些客户可能流失。

- 疾病诊断: 基于患者症状和检查结果,辅助医生进行疾病诊断。

- 风险评估: 在金融领域,用于评估贷款申请人的信用风险。

- 欺诈检测: 通过分析交易记录,识别潜在的欺诈行为。

参考资料:

机器学习