原文:https://mp.weixin.qq.com/s/i-o68QcHK6KsUC8YrWuVjA

论文:Mobile-Agent-v3: Fundamental Agents for GUI Automation

github: https://github.com/X-PLUG/MobileAgent

全文摘要

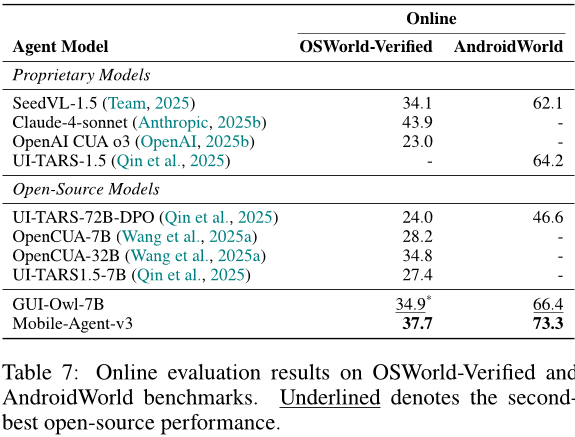

本文介绍了一种名为Mobile-Agent-v3的通用GUI代理框架,该框架基于开源模型GUI-Owl,并在其基础上进行了进一步的性能提升。GUI-Owl是一种基础GUI代理模型,可以在桌面和移动环境中实现地面上下文理解、问答、规划、决策和一般性程序知识。此外,该模型还具有大规模环境基础设施、多样化基础代理能力构建和可扩展环境RL等关键创新点。实验结果表明,Mobile-Agent-v3在AndroidWorld和OSWorld基准测试中分别取得了73.3和37.7的成绩,达到了新的GUI代理框架中的最佳水平。

论文方法

方法描述

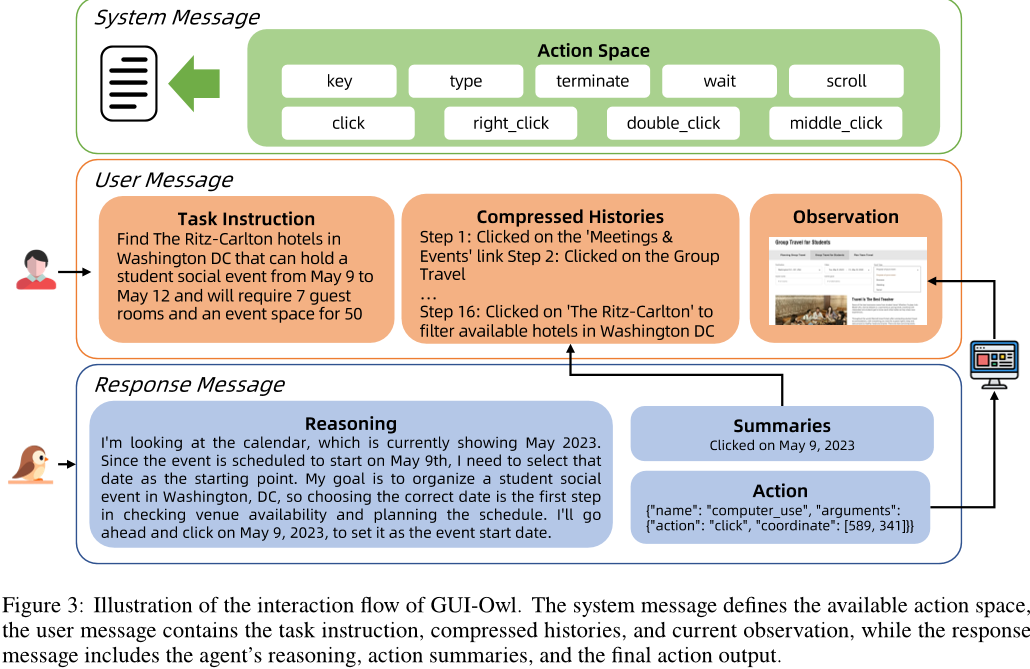

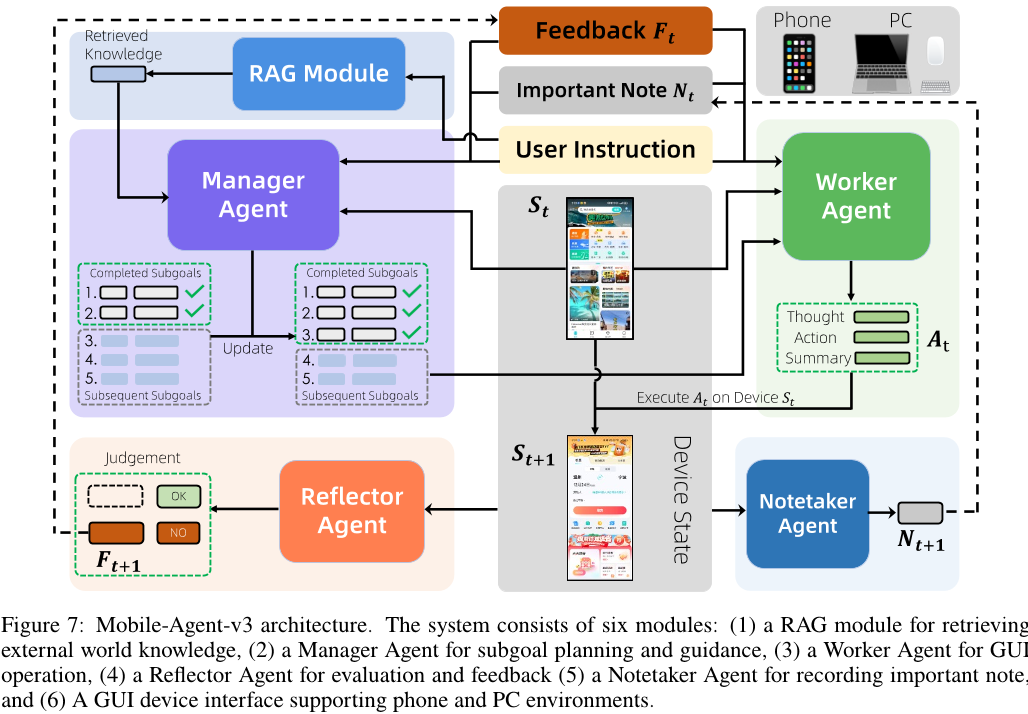

该论文提出了一种名为“GUI-Owl”的多模态强化学习框架,用于实现复杂图形用户界面(GUI)任务的自动化。该框架采用了多种数据合成策略来增强模型的推理能力,并引入了迭代在线拒绝采样、自适应奖励函数等技术来提高模型的性能。此外,该论文还介绍了Mobile-Agent-v3多代理协作框架,通过四个专门的代理来实现任务规划、子任务执行和反思推理等功能。

方法改进

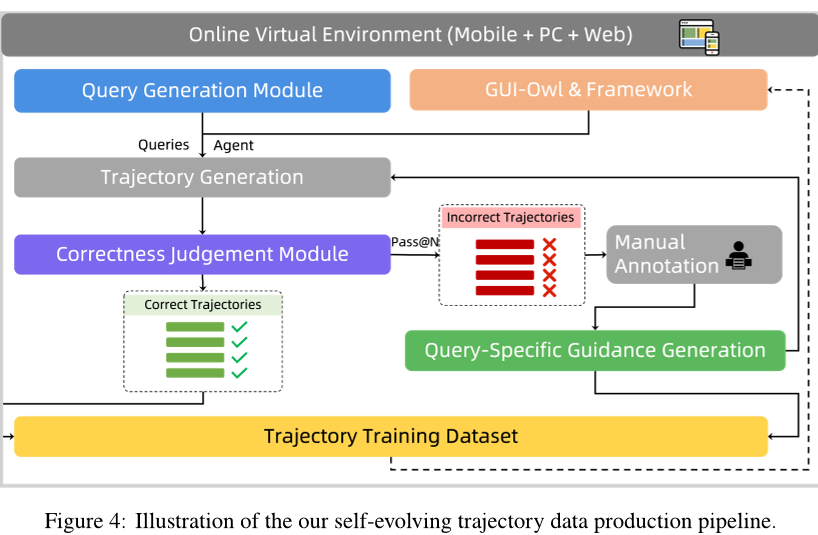

与传统的基于手动标注的方法相比,GUI-Owl框架利用自我监督的方式生成大量的高质量交互轨迹数据,从而减少了人工标注的需求。同时,该框架采用了大规模预训练、迭代调优和强化学习等多种技术手段,进一步提高了模型在实际应用中的稳定性和可靠性。此外,Mobile-Agent-v3多代理协作框架通过将任务分解为多个相对简单的子任务,并由不同的代理协同完成,实现了更加高效的任务自动化。

解决的问题

该论文主要解决了图形用户界面任务自动化的挑战问题,包括数据集规模小、人工标注成本高、模型泛化能力差等问题。通过使用自我监督和大规模预训练等技术手段,GUI-Owl框架能够生成大量高质量的交互轨迹数据,从而降低了人工标注的成本;而Mobile-Agent-v3多代理协作框架则通过将任务分解为多个相对简单的子任务,并由不同的代理协同完成,实现了更加高效的任务自动化。这些技术手段的应用使得GUI-Owl框架能够在真实环境中实现更加可靠、稳定的自动化任务处理。

论文实验

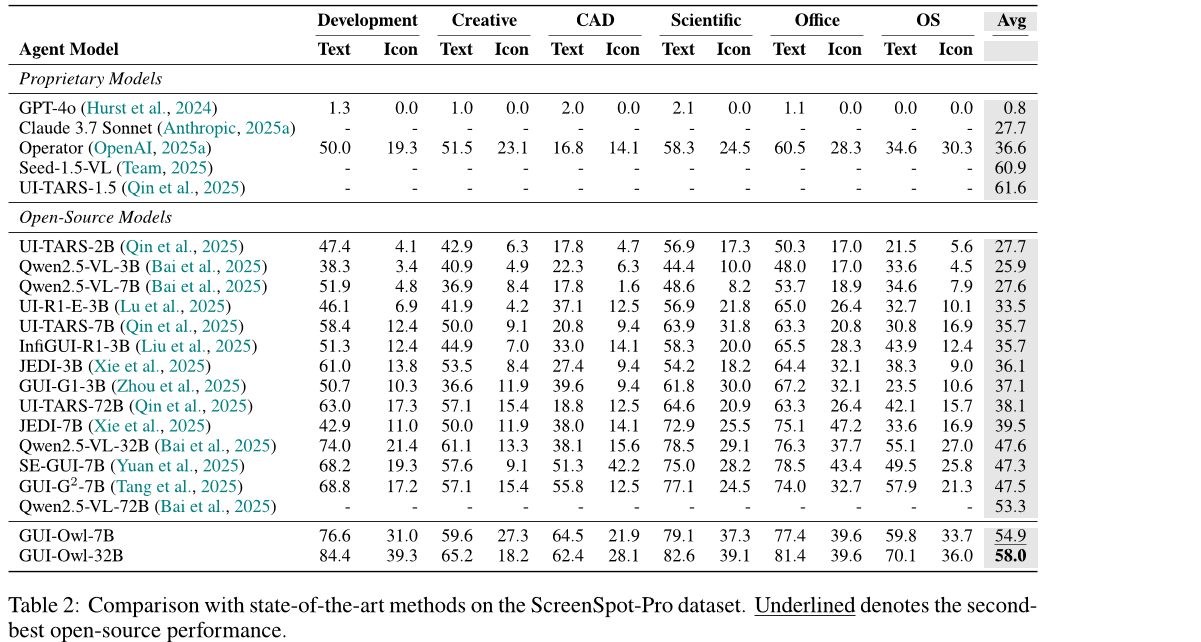

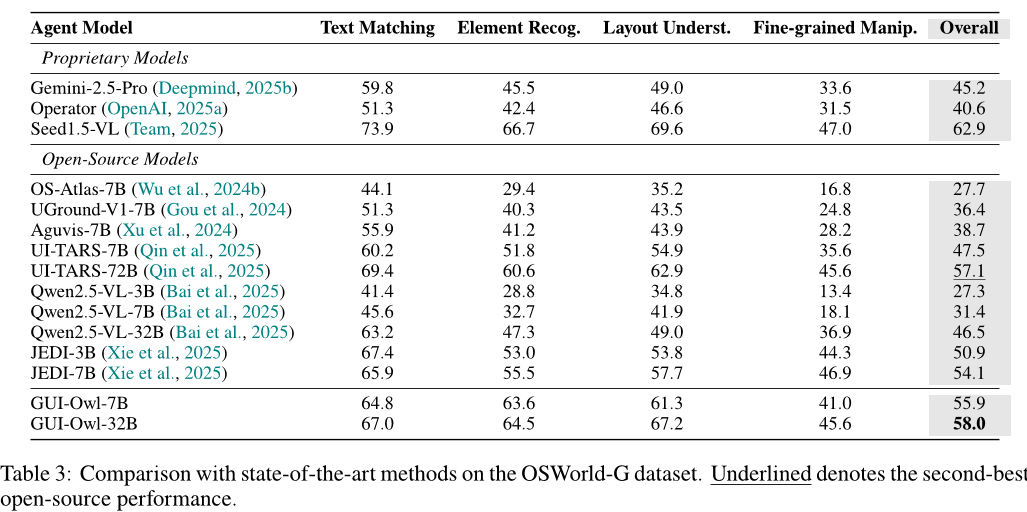

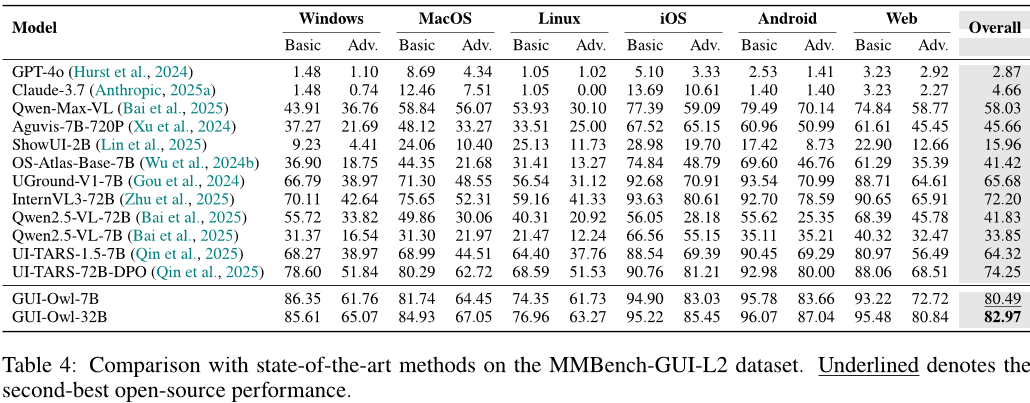

本文主要介绍了基于视觉语言模型的 GUI 自动化系统 GUI-Owl 的性能评估和优化方法。文章中包含了四个关键维度的评估:地面能力、全面 GUI 理解、端到端代理能力和多代理能力的比较。在每个维度下,都进行了详细的实验设计和结果分析。

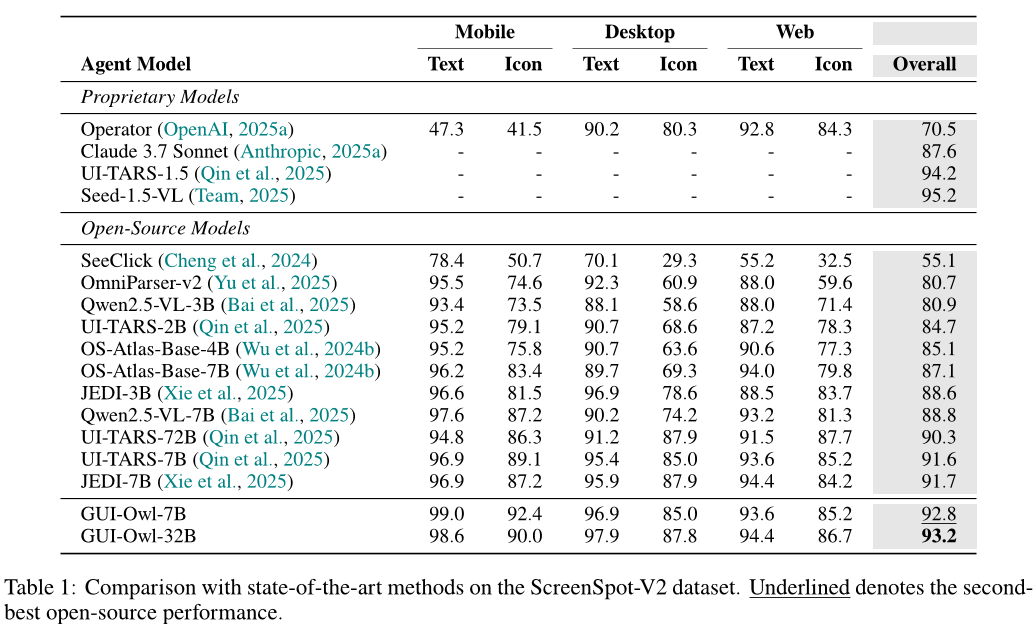

在地面能力方面,作者使用了两个基准数据集(ScreenSpot 和 OSWorld-G)来评估 GUI-Owl 在定位 GUI 元素方面的表现,并与其他模型进行了比较。结果显示,GUI-Owl 在这两个基准上均取得了最好的成绩,证明其具有较强的地面能力。

在全面 GUI 理解方面,作者使用了两个基准数据集(MMbench-GUI L2 和 Mobile Control)来评估 GUI-Owl 对于屏幕状态的理解和单步决策的能力,并与其他模型进行了比较。结果显示,GUI-Owl 在这两个基准上均取得了较好的成绩,证明其能够准确理解屏幕状态并作出正确的决策。

在端到端代理能力方面,作者使用了两个基准数据集(AndroidWorld 和 OSWorld)来评估 GUI-Owl 在复杂任务中的表现,并与其他模型进行了比较。结果显示,GUI-Owl 在这两个基准上均取得了较好的成绩,证明其能够在真实环境中完成复杂的 GUI 任务。

在多代理能力方面,作者将 GUI-Owl 集成到了两个不同的框架中(Mobile-Agent-E 和 Agent-S2),并与多个其他模型进行了比较。结果显示,GUI-Owl 在这两个框架中均取得了较高的成功率,证明其具有良好的多代理适应能力。

此外,文章还介绍了 GUI-Owl 的训练数据生成管道以及优化方法,包括自演化轨迹数据生产、高质量查询生成、轨迹正确性判断模块等。这些方法可以提高 GUI-Owl 的性能和效率,使其成为一个更加强大和可靠的 GUI 自动化系统。

论文总结

文章优点

- 本文提出了一种全新的GUI自动化模型GUI-Owl,该模型将感知、接地、推理、规划和行动执行整合在一个可扩展框架中。

- GUI-Owl使用Qwen2.5-VL进行训练,并在大规模、多样化的GUI交互数据上进行了广泛的后处理,取得了在各种具有挑战性的基准测试中的最先进的性能表现。

- 通过合成推理数据和可扩展强化学习框架,GUI-Owl能够实现灵活的决策制定,从单个自主执行者到协作多代理角色协调。

方法创新点

- GUI-Owl是一种端到端的多模态代理模型,它将感知、接地、推理、规划和行动执行整合在一个可扩展框架中。

- 该模型使用了Qwen2.5-VL进行训练,并在大规模、多样化的GUI交互数据上进行了广泛的后处理,使其能够在各种具有挑战性的基准测试中取得最先进的性能表现。

- 通过合成推理数据和可扩展强化学习框架,GUI-Owl能够实现灵活的决策制定,从单个自主执行者到协作多代理角色协调。

未来展望

- GUI-Owl可以应用于各种GUI自动化任务,包括文本编辑、文件管理、图像处理等。

- 未来的研究方向可能包括进一步提高GUI-Owl的性能和效率,以及将其与其他技术结合使用,以实现更复杂的任务。